Eerder sprak ik al over het feit dat het lastig is om meetresultaten te vertalen naar praktische applicaties. De applicatie IOmeter is weliswaar een echt oudje als het om software gaat, de software stamt namelijk uit 1998, maar waar de software voorheen gebruikt werkt om de prestaties te meten van harde schijven en zelfs de schijfprestaties van complete serveromgevingen laat deze zich ook prima toepassen op SSD’s en het simuleren van verschillende gebruiksdoeleinden.

IOmeter is echter een complex stukje software. Je kan met een praktisch eindeloos aantal instelmogelijkheden niet alleen tal van scenario’s simuleren, maar vooral ook jezelf hoofdpijn bezorgen of grote invloed uitoefenen op de resultaten, vandaar de eerste reden voor de naam van dit hoofdstuk. Wees daarom alert dat je IOmeter resultaten van één reviewer niet klakkeloos vergelijkt met die van een andere.

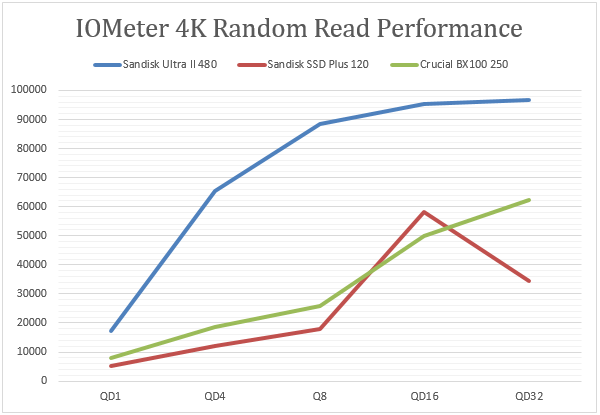

De tweede reden achter de naam voor dit hoofdstuk is het feit dat zelfs wanneer je een gangbaar (andere reviews / populaire meetmethodes) patroon gebruikt je met de kleinste details alsnog gevolgen in de resultaten kan zien afhankelijk van het soort SSD en de manier waarop deze is opgebouwd. We beginnen met een eenvoudige 4K leestest die voor gangbaar consumenten gebruik relevant is, en als je vaker SSD reviews hebt gelezen komt die ‘4K test’ je natuurlijk bekend voor. Daar zien we dat de Ultra II extreem veel sneller is dan de SSD Plus, en de Crucial BX100 250GB. De Ultra II kan dus lezen als een beest.

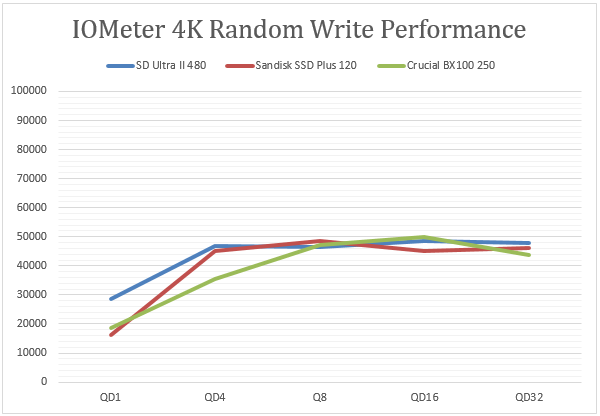

In de schrijftest zien we de resultaten flink wat dichter bij elkaar zitten, opvallend dicht zelfs, al is het begin van de grafiek (lagere queue depth) wat relevanter voor de (consumenten) doelgroep, en toont de Ultra II zich dus nipt een winnaar met een voorsprong bij de zeer lage QD.

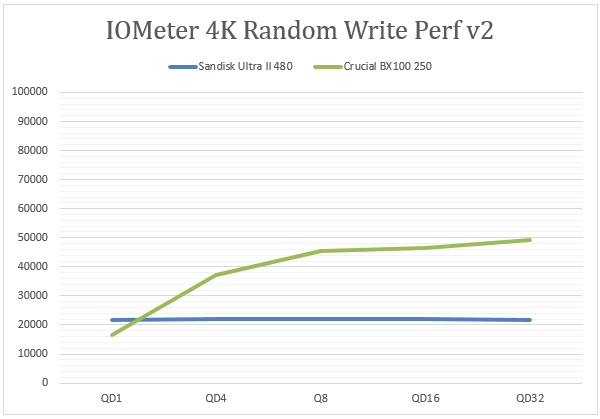

Maar waarom dan zo’n onaardige titel? Dat ziet er toch allemaal prima uit? Well, laten we kijken wat er gebeurt met de Ultra II als we wat aan de instellingen gaan zitten. We laten IOmeter nog altijd op de veel voorkomende 4K Random Write instelling staan, maar we gaan aan wat algemene instellingen prutsen: Bijvoorbeeld dat SSD’s de hele schijf moeten vullen in plaats van enkel een blok van 10GB (een gangbare meetmethode), of simpelweg vertellen specifieke sectoren op de SSD te moeten gebruiken.

Whoops? Tegen de 22000 IOPS bij welke queue depth dan ook, terwijl de Crucial BX100 grofweg dezelfde lijn als voorheen volgt. De Ultra II lijkt spontaan een matige schrijvende SSD? Grafiek-magie zonder dat ik op goedkope wijze de afstelling van de assen aan hoef te passen. Overigens is dit slechts één voorbeeld, als ik een medewerker van de marketing afdeling zou zijn zou ik met IOmeter lekker los kunnen om grafieken helemaal in eigen voordeel op te stellen.

Heel complex is de uitleg niet. SanDisk past namelijk een techniek die zij nCache noemen toe in de Ultra II series, waarbij de 480GB aan TLC chips op de SSD worden bijgestaan door een kleinere hoeveelheid snellere SLC cache. Vergelijkbare technieken worden inmiddels in veel SSD’s vandaag de dag toegepast: snellere cache gebruiken voor het initiele werk, en de tragere (nou ja, traag…) chips het uiteindelijk opslaan voor hun werk laten nemen. Uiteraard technisch niet heel eenvoudig, maar vergelijkbaar voor de gebruiker met bijvoorbeeld werkgeheugen versus opslag, of cache in mechanische harde schijven. Nog een beter voorbeeld: SSHD’s waar mechanische schijven worden bijgestaan door een kleine hoeveelheid ‘SSD’. Het gevolg is dat bij schrijfacties van hooguit enkele GigaBytes het snellere geheugen wordt gebruikt terwijl de SSD vervolgens in de achtergrond de data rustig verdeelt, en bij gigantische schrijfacties waarbij de cache het niet meer aan kan de prestaties inzakken. Het beoordelen van dergelijke prestaties is logischerwijs niet eenvoudig en het is cruciaal om het gebruiksdoel in het achterhoofd te houden. Vanuit een consument, een fotograaf, of een gamer, is de winst van de paar snellere chips praktisch uitstekend zonder dat je een flink duurdere schijf hoeft te kopen. De keuze om SSD’s als zodanig op te bouwen is dan ook begrijpelijk.

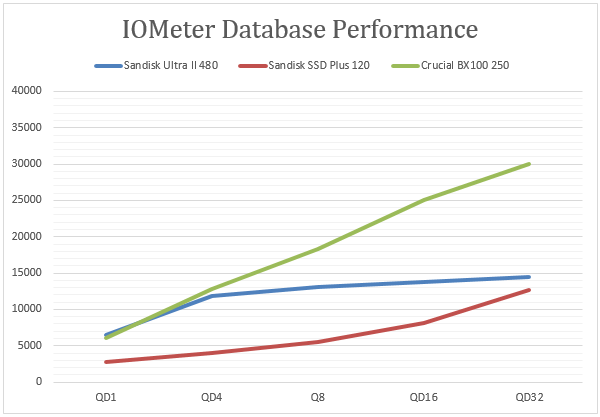

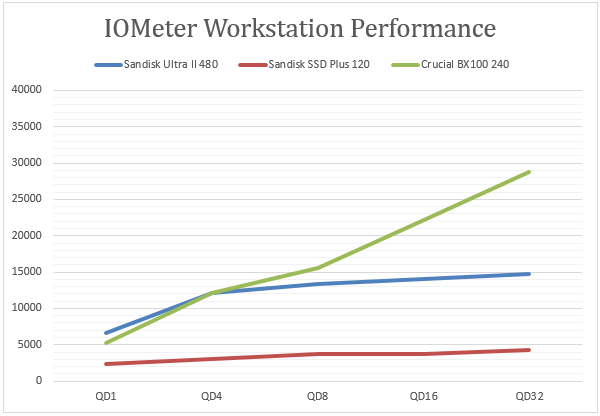

Voor zeer intensief gebruik, bijvoorbeeld in pittig workstation gebruik, of bij een grote database die intensief wordt gebruikt, is het wenselijk dat de prestaties consequent hoog liggen. Waar ik bij de 4K tests dus de voorkeur geef aan de resultaten waar de cache zijn werk kan doen mag de Ultra II dat voordeel niet hebben bij dit zwaardere, primair zakelijke gebruik. Toegegeven, met een kleine of niet zwaar beladen database zou je nog kunnen teren op de nCache en een mooiere grafiek neer kunnen zetten, maar we kunnen niet alle gebruiksdoelen indekken.

Zien we de Ultra II bij een lage queue depth nog concurreren, bij een hogere QD, iets wat ook zeker waarschijnlijk is bij echt intensief gebruik, valt deze op een gegeven moment flink achter. Dit komt uiteraard omdat beide tests een noemenswaardig deel schijfacties hebben, en deze in deze test dus niet meer ‘vrij’ door de cache kunnen worden afgehandeld maar direct op het ‘tragere’ deel komen. De SSD Plus heeft het nog lastiger, niet onverwacht keihard wordt die afgestraft in deze zware test. Zakelijke SSD’s of Database SSD’s zijn beide dus zeker niet, en de consumenten aard van de beestjes wordt nog duidelijker bij het zien dat er geen encryptiemogelijkheden in de schijven zitten.