Gigabyte GeForce GTX 1070 G1 Gaming review

Productpagina @ Gigabyte

We hebben het afgelopen jaar veel grafische kaarten mogen testen, niet heel vreemd gezien AMD met drie nieuwe chipsets aan kwam zetten, en Nvidia zelfs met meer dan ik op één hand kan tellen (verder dan dat tel ik overigens niet, laten we het gewoon ‘veel’ noemen). Één van de eerste nieuwe chipsets van dit jaar was de Nvidia GTX 1070 en bij het reviewen van de eerste GTX 1070 kaart was het een beetje afwachten wat de prijs ging doen. Enkele maanden later kunnen we nog vrij zeker stellen dat de GTX 1070 nog enige tijd de Nvidia subtopper zal blijven, terwijl de straatprijzen ook aardig gestabiliseerd zijn: rond de 450 euro kom je de eerste, veelal eenvoudige of dual-fan modellen tegen, rond de 500 is je keuze reuze en voorbij dat punt zien we de topmodellen van de verschillende fabrikanten, al dan niet gecombineerd met waterkoeling voor nog een paar tientjes meer.

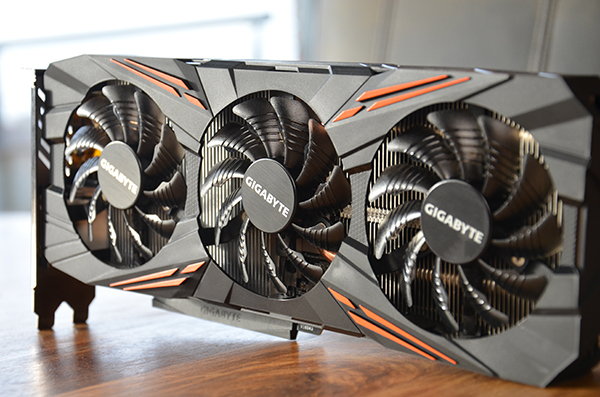

De kaart waar we naar gaan kijken is de Gigabyte GeForce GTX 1070 G1 Gaming welke te vinden is voor ca 475 euro. Deze kaart kenmerkt zich wel met een aardige fabrieksoverclock, drie-fan koeloplossing, backplate, en RGB LED feature, maar zit wat prijs daarmee nauwelijks boven de instappers; een goed begin. Ook voor onze reviews interessant, want de Gigabyte G1 Gaming uitvoering is een stuk goedkoper dan de eerder door ons geteste MSI en ASUS variant, kaarten waar Gigabyte dan weer de Xtreme Gaming variant direct tegenover zet.

Met de ruwe prestaties van de GTX 1070 chip inmiddels wel bekend, we hebben tenslotte eerder twee andere GTX 1070’s getest, gaan we ons dan ook focussen op de onderlinge verschillen en in hoeverre het wijsheid is om te investeren in een nog luxere uitvoering of juist niet; met zijn huidige prijsstelling is de G1 Gaming namelijk de goedkoopste in de lijst. Ook zullen we niet elk hoofdstuk voor de derde keer herhalen en slaan we er een paar over, in deze review brengen we alle resultaten en ervaringselementen dan ook in één iets langere conclusie samen. Zij die eerdere reviews hebben gevolgd kunnen in de conclusie dan alle relevante informatie binnen 1 minuut tot zich nemen.

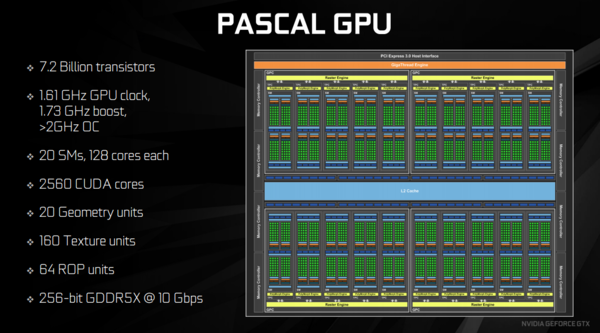

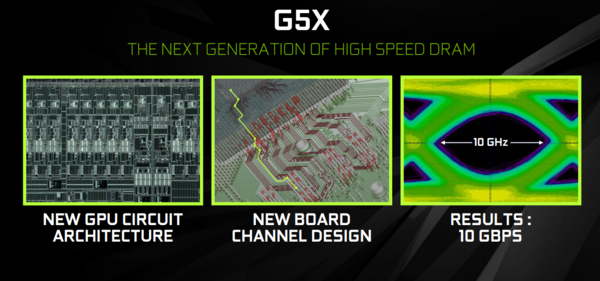

Alvorens we naar de specifieke Gigabyte uitvoering gaan kijken eerst weer even een blik op de onderliggende Nvidia chip, de GP104. Zo zien we dat vergeleken met de vorige generatie dat er bijna 40% meer transistors zitten op een oppervlak dat iets meer dan 20% kleiner is geworden; efficiëntie en vooruitgang woohoo.

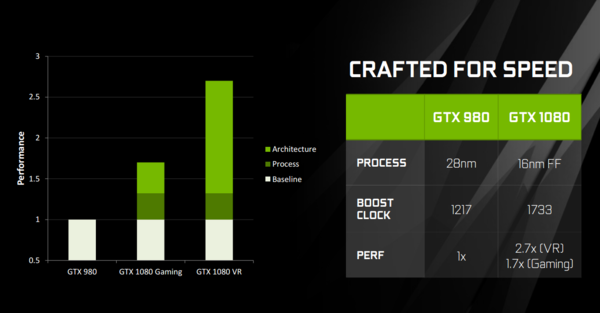

De GP104 bevat 2560 Cuda rekenkernen, waarvan de GTX 1080 ze allemaal heeft ingeschakeld, en de GTX 1070 weliswaar gebaseerd op dezelfde chip is maar waar wel een stukje is uitgeschakeld. Naast dat de nieuwe generatie meer cores heeft draaien ze ook een stuk sneller, want we zien een basis snelheid van 1733 MHz, terwijl we GTX 970’s en GTX 980’s met een beetje geluk 1500MHz zagen aantikken na wat overclocken.

Praktisch van aard is de aanwezigheid van hardwarematige x265 / HEVC decoding, wat we op de GTX 950 en 960 tegen kwamen, maar op de vorige generatie high-end moesten missen. Ook Ultra HD (4K) beelden op 60FPS naar je moderne televisie sturen is geen enkel probleem. Vermoedelijk iets meer in de toekomst voor home cinema fanaten is de ondersteuning van HDR beelden welke aanwezig is in deze generatie.

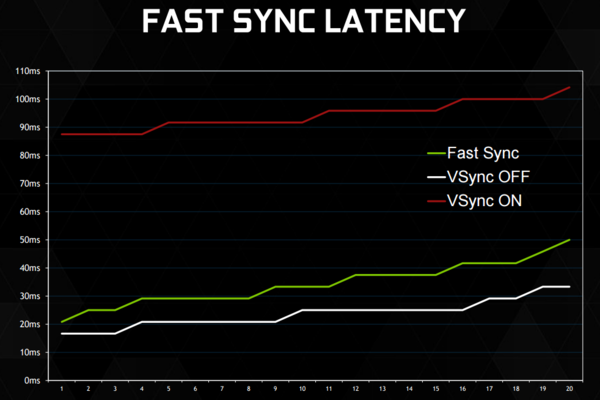

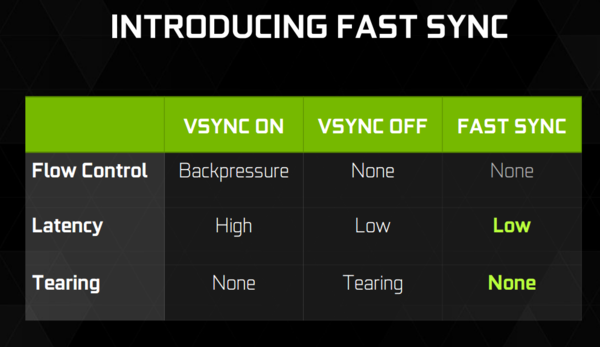

Voor de gamers is er ‘Fast Sync’. Lang verhaal kort: De al-oude V-sync instelling voorkomt ‘screen tearing’ maar zorgt in feite voor een marginale vertraging. Geen vertraging die de gemiddelde casual merkt, maar funest voor competitieve play. Fast sync lost dit laatste grotendeels op en maakt in theorie dus een einde aan screen tearing, wat zeker nog speelt op niet-extreem-snelle schermen.

Voor gamers met een meer artistieke of sociale insteek (lees: streamen of anderzijds delen van gameplay) is Ansel een aardig nieuwtje. Games die dit ondersteunen laten je wanneer gewenst een screenshot maken, maar geven je op dat moment volledige camera vrijheid om dit te doen. Het maakt je game niet sneller, maar met de populariteit van het delen van de ervaringen toch een slim bedacht nieuwtje.

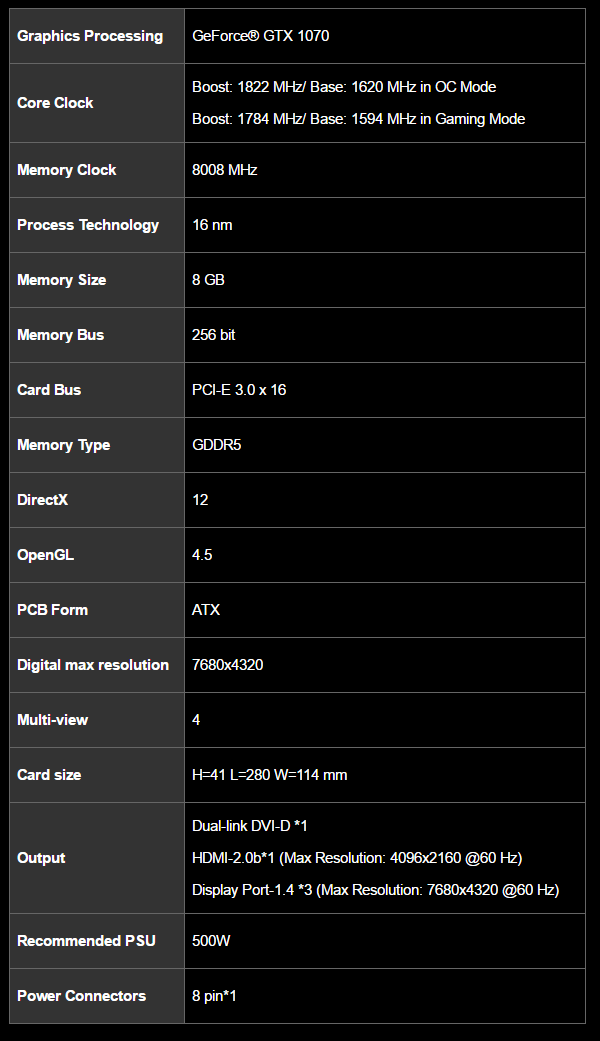

Terug naar de ouderwetse werkelijkheid van het reviewen: De specificaties:

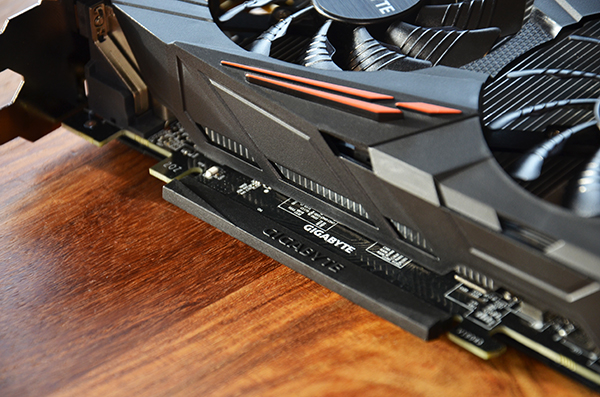

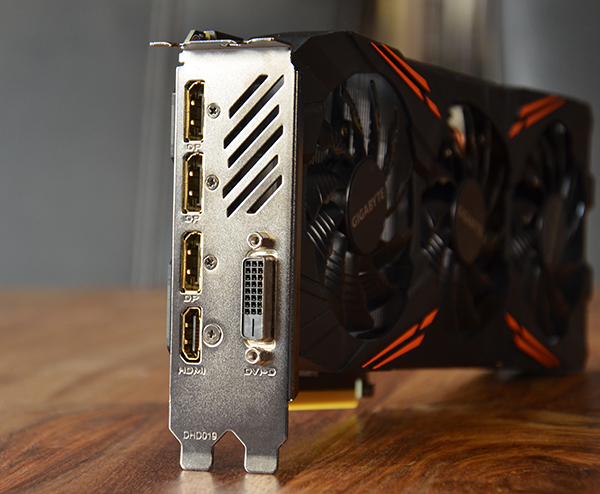

De Gigabyte GeForce GTX 1070 G1 Gaming is een ‘factory overclocked’ kaart, waarbij de maximale boost snelheid is opgekrikt naar 1,822GHz in de boost modus. Om de kaart van wat prik te voorzien is een enkele 8-pin PCI Power aansluiting vereist. Gigabyte houdt met 3 Displaypoorten aangevuld met één HDMI en één DVI-D uit vast aan de originele plannen van Nvidia. Specificaties van de poorten, 1.4 voor DP en 2.0b voor HDMI zijn ongewijzigd. Gezien het een DVI-D uitgang betreft is het niet mogelijk om (al dan niet met adapters) een VGA scherm aan te sturen.

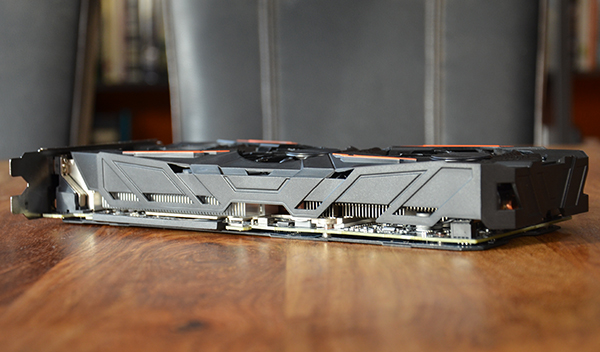

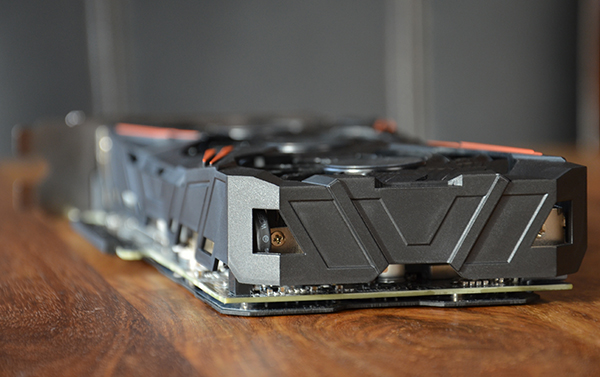

Fysiek is de kaart een dubbelslotter en iets langer dan de Founder’s Edition, marginaal langer dan de MSI Twin Frozr die we eerder bekeken, en weer een stukje korter dan de ASUS ROG Strix uitvoering van onze review afgelopen oktober. Voor eigenaren van ietwat smallere behuizingen is de breedte van Gigabyte echter een interessant gegeven: hij is namelijk nauwelijks breder dan de expansie sloten zelf, een richtlijn waar die twee concurrenten maling aan hadden. Dat laatste is probleem in een dikke kast, maar we hebben er ook aardig wat meegemaakt waar een dikke kaart + stroomaansluitingen niet of nauwelijks paste. Pluspunten voor Gigabyte dus op dit vlak.

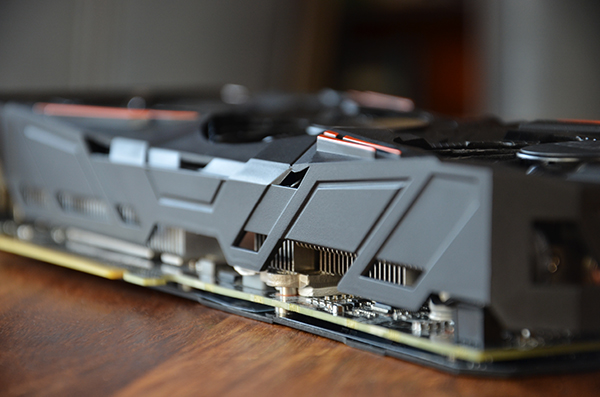

Naast de harde specs zien we ook de focus features van Gigabyte op de productpagina: RGB LED feature, drie-fan design met opvallende en volgens hen efficiënter blade design en ventilatoren die stilstaan bij eenvoudig gebruik.

Wie in de laatste jaren een Gigabyte grafische kaart heeft gekocht zal de verpakkingen direct herkennen. Verder ontlopen de verschillende merken elkaar wat unbox ervaring weinig: karton doosje in een gekleurd hoesje, maar who cares really want we willen gewoon dikke kaarten zien!

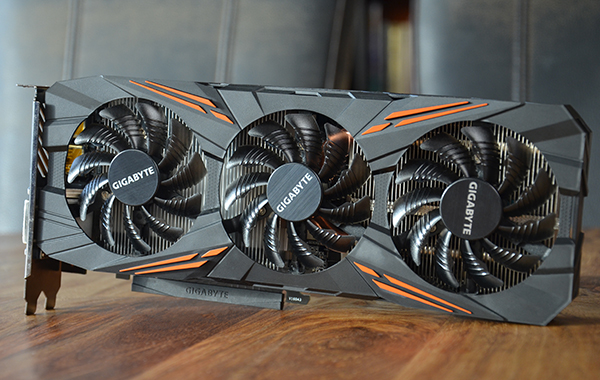

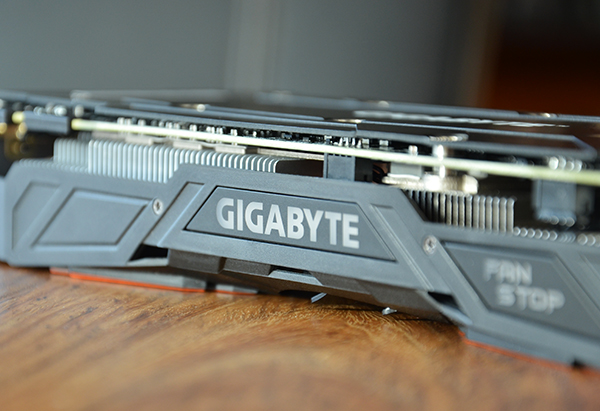

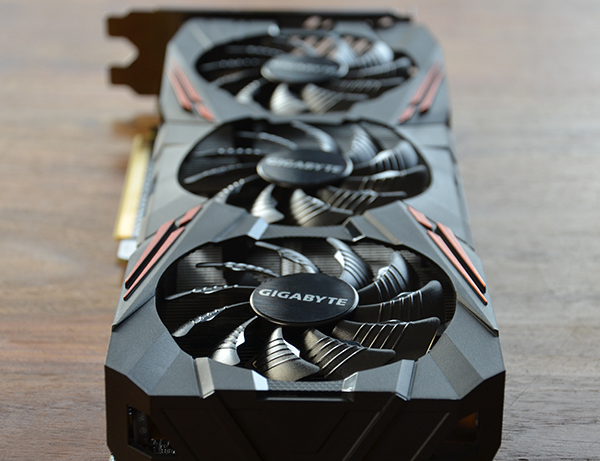

En de Gigabyte GeForce GTX 1070 G1 Gaming mag zich van mij oprecht een dikke kaart noemen, Gigabyte mag de Xtreme Gaming uitvoering er nog wel boven zetten, maar de eerste indrukken zijn die van een ‘luxe’ uitvoering. Niet overdreven dat je je afvraagt wat je ermee moet, maar absoluut geen klagen wat de algemene indrukken betreft, en in de zoom-ins zie je ook dat er wat afwerking betreft ook echt niks te klagen valt. Het grotendeels zwart/grijze design, aangevuld met enkel een oranje lijntje die je veelal niet of nauwelijks zal zien, laat zich in de meeste gevallen dan ook prima combineren met andere hardware, wat ook als plusje mag gelden. In het rondje om de kaart zien we wel dat Gigabyte het ontwerp aan alle kanten redelijk gesloten heeft gehouden, daarvan moeten we straks zien of dat geen gevolgen heeft voor de koelprestaties.

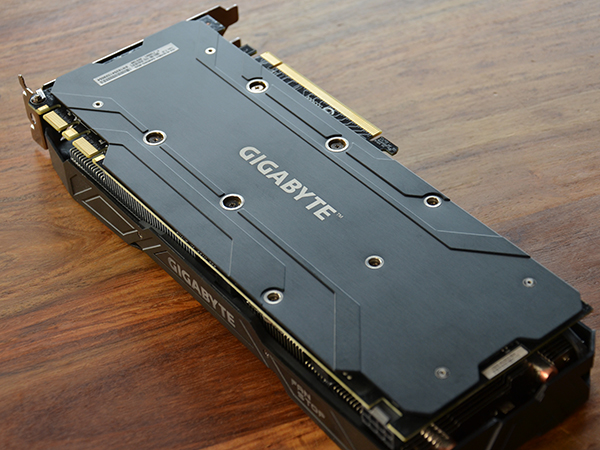

Iets waar wat voordeligere uitvoeringen soms in snijden, de backplate, ontbreekt hier gelukkig niet. De Gigabyte GeForce GTX 1070 G1 Gaming komt met een metalen backplate die uitstekend voor de dag komt, en weinig poespas heeft. Gezien je in een typische ATX toren vooral die backplate zal zien is de neutrale kleurstelling wederom positief. Onder de juiste hoek en van dichtbij zie je de lijntjes in het metaal zitten voor een mooi effect, maar in de praktijk zal het vooral een strak zwarte plaat zijn.

Dan de aansluitingen zoals in de specs gezien: Driemaal DP, éénmaal HDMI en éénmaal DVI-D, goed voor heel erg veel pixels.

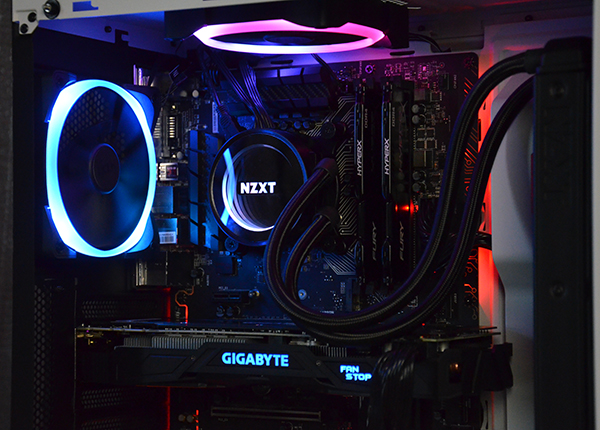

Dan nog even wat plaatjes in een echte build: Zoals je ziet laat de Gigabyte GeForce GTX 1070 G1 Gaming zich goed combineren, en zijn de oranje lijntjes niet echt een issue in een typische setup, al zal dat altijd een persoonlijke overweging blijven. De RGB feature is verder bescheiden met enkel het logo en de fan-stop indicator die oplichten, maar het is meer dan voldoende om de kaart aan te laten sluiten op welke kleur setup dan ook. Voor zij met een regenboog RGB verlichting kan je de Gigabyte GeForce GTX 1070 G1 Gaming ook op colour cycle zetten, maar synchronisatie met andere hardware anders dan van Gigabyte zelf is er uiteraard niet.

en.. een gifje natuurlijk!

Na een hele zwik kaarten op dezelfde manier getest te hebben liep ik helaas tegen problemen op met mijn oude moederbord. Hoewel een oplossing in de vorm van een stapeltje nieuwe hardware eenvoudig is om op te zetten hebben we een tijdje geleden flink moeten testen met zowel de i7-4770k, i7-4790k, en twee i7-6700k’s om zeker te zijn dat de resultaten uit het verleden nog altijd representatief zijn, niet alle GPU’s uit het verleden liggen hier nog om te verifiëren, maar met RX 470 en RX 480 uit het rode kamp, en een GTX 1050, GTX 1050Ti, GTX 970, GTX 1070 en GTX 1080 uit het groene kamp was er een degelijke basis om te kunnen concluderen dat wij op de hieronder gestelde manier verder konden met behoud van enkele eerdere resultaten. Gelukkig bleek de invloed van de CPU en DDR4 in onze benchmarks veelal beperkt tot niet significante verschillen, iets wat ik gezien een aantal oudere tests op basis van driver updates alleen al had verwacht (aan de andere kant, de meeste oudere games was natuurlijk al voor geoptimaliseerd). Enkele iets oudere games op lagere instellingen bleken wel CPU beïnvloed, maar gezien de praktische waarde van die benchmarks en settings (veelal benchmarks die dan ver voorbij de 150 FPS uitkwamen) hebben we die bij deze geheel laten vallen. Ter compensatie zullen in de toekomst uiteraard nieuwe games worden toegevoegd, zodra er in die grafieken iets te vergelijken valt.

De testopstelling is nu als volgt:

Processor: Intel Core i7-6700K

Moederbord: MSI Z170A Gaming Pro Carbon

Geheugen: Kingston HyperX Fury 16GB 2400MHz

Voeding: Cooler Master V-Series V750

Opslag: Crucial MX 300 SSD

Behuizing: Cooler Master Test Bench

Alle kaarten worden getest met de instellingen zoals ze uit de fabriek komen, fabrieks-overklok instellingen blijven dus in tact. Verder overklokken en eventueel resultaten die daarbij van toepassing zijn worden in de individuele reviews onder de header “overklokken” besproken. Indien geen resolutie is gespecificeerd mag je uitgaan van 1080p. Alle benchmarks zijn om uitschieters te voorkomen drie maal uitgevoerd, waarbij het gemiddelde wordt weergegeven. Bij noemenswaardige afwijkingen tussen de drie onderlinge resultaten wordt de benchmark nogmaals meerdere malen uitgevoerd om zo zeker te zijn van een betrouwbaar resultaat.

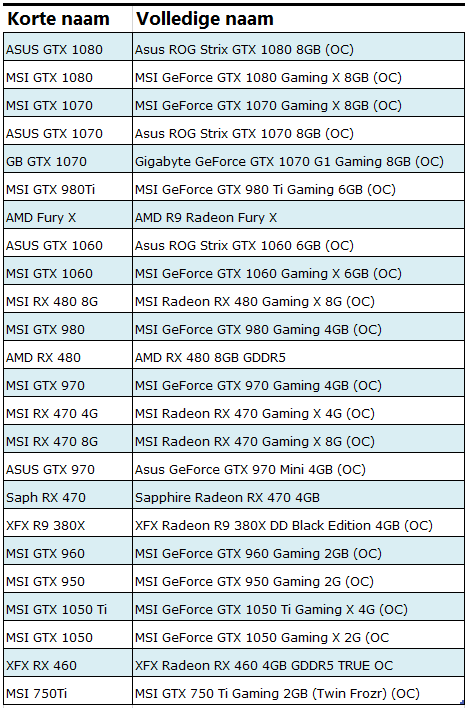

Omdat het niet praktisch is in alle grafieken de gehele naam van elke kaart te gebruiken maak ik gebruik van afkortingen, in deze tabel zie je de exact gebruikte kaarten:

Een belangrijke opmerking met betrekking tot de drivers. Driver updates geven soms wat prestatieverbeteringen, maar veelal in specifieke games. Een vergelijking maken met een oudere kaart op oudere drivers is dan ook niet altijd 100% eerlijk, ondanks dat we geen noemenswaardige verschillen zagen tussen de tests van enkele maanden geleden op een i7-4770k en de recentere tests. De meeste games in deze vergelijking zijn echter al eventjes uit, dus de kans dat een nieuwe driver verder geoptimaliseerd is voor die game is dan minder groot. Het is echter sowieso onvermijdelijk: Soms zullen er nu eenmaal nieuwe kaarten uitkomen die nieuwere drivers vereisen om te functioneren waardoor testen met één driver niet mogelijk is. De driver versie waarop is getest is vanaf heden onder de header specificaties terug te vinden.

Alle games in deze review hebben een geïntegreerde benchmark. Dit zorgt voor een eerlijke vergelijking tussen de kaarten, de gebruikte instelling staat in de header van elke grafiek.

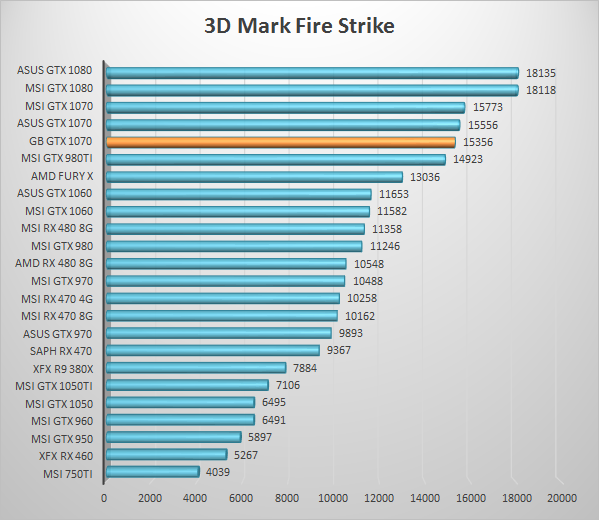

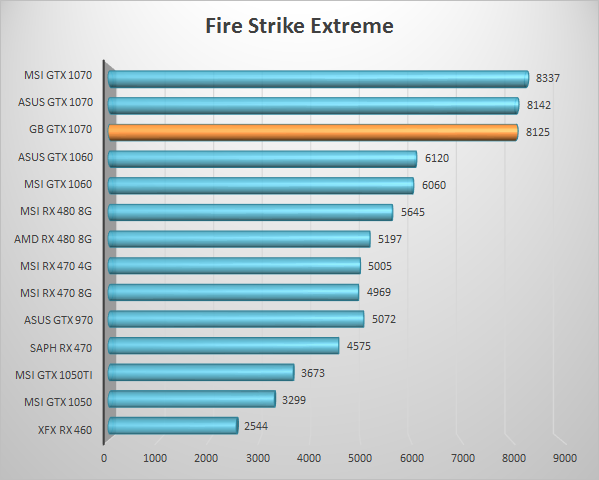

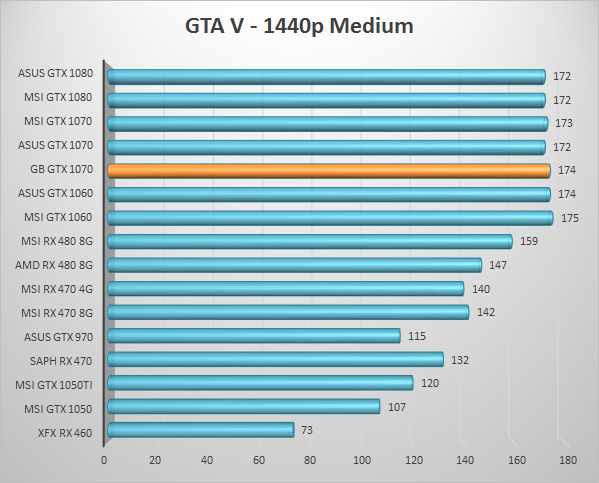

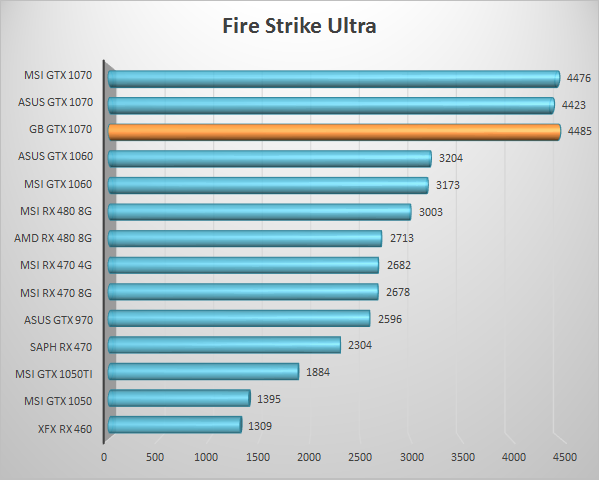

Laten we beginnen met toch wel de grote single GPU benchmark: 3D Mark FireStrike. Deze resultaten zijn nog altijd representatief voor onderlinge krachtverschillen en deze ranking pinnen we dan ook vast in alle onderstaande grafieken: zo zie je de directe concurrenten consequent direct naast de kaart in test.

Benchmarks!

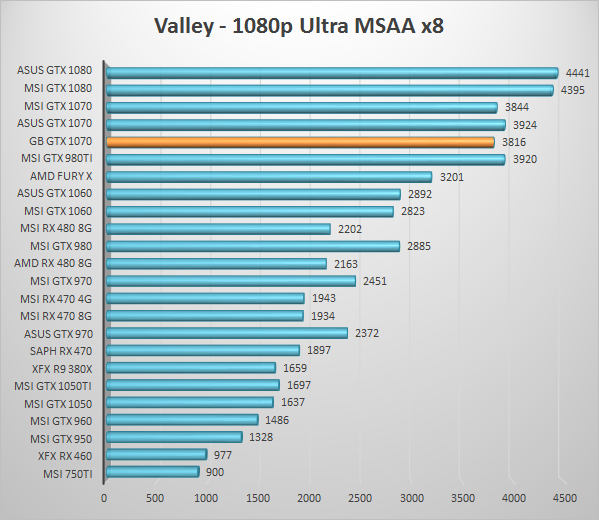

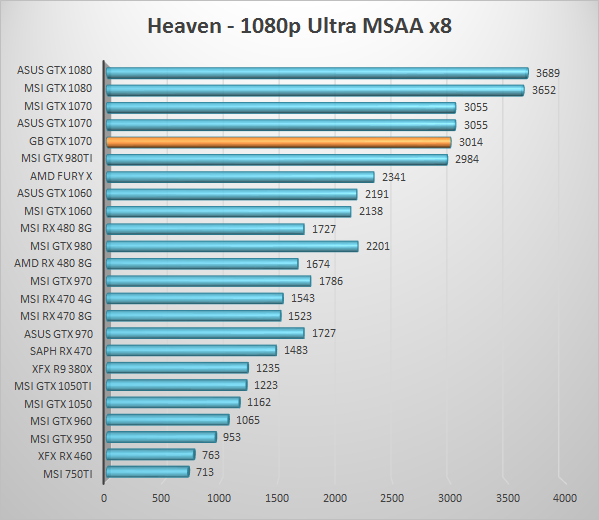

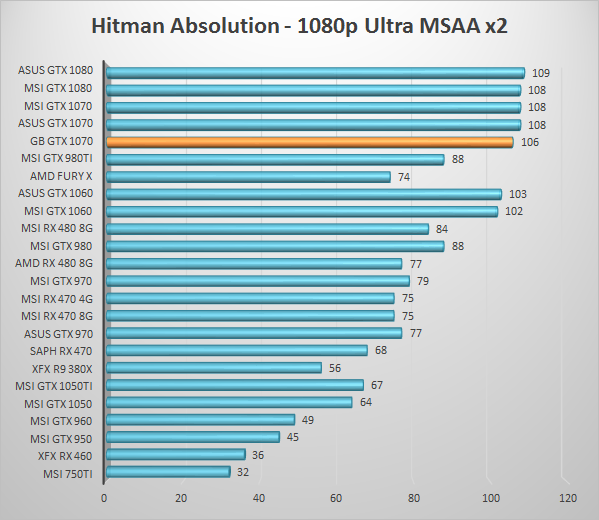

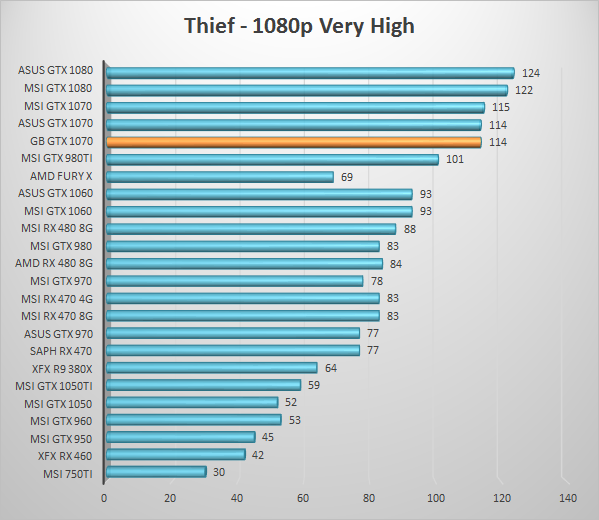

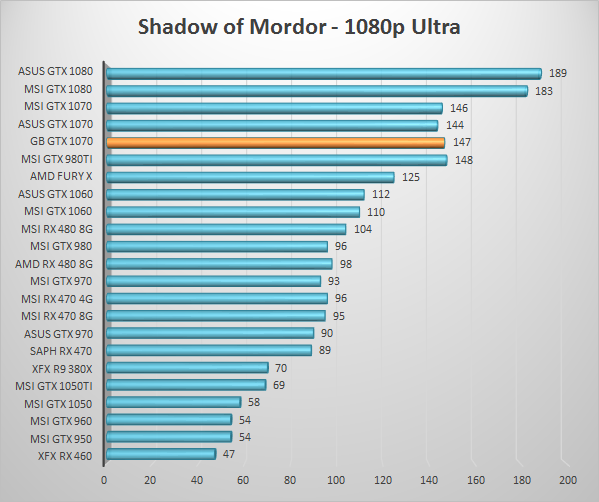

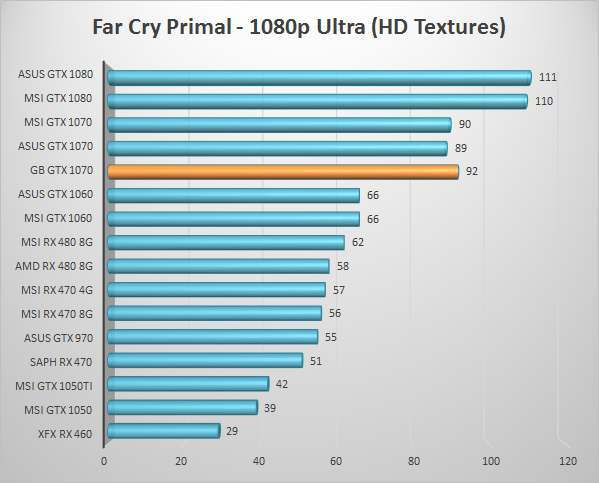

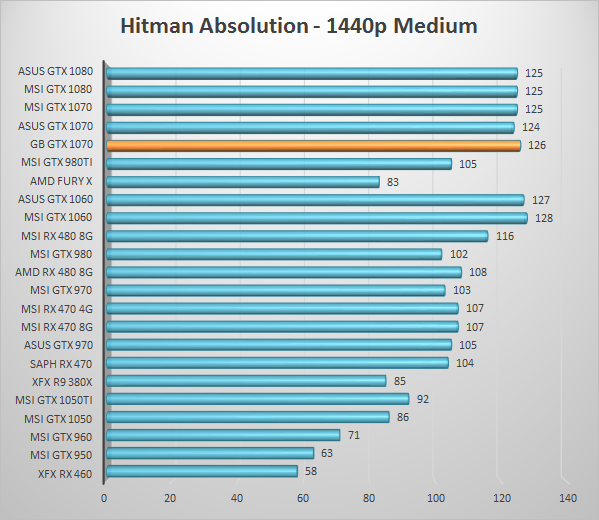

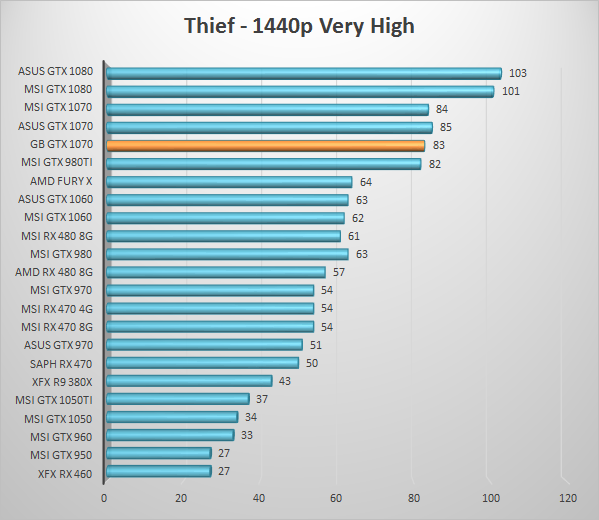

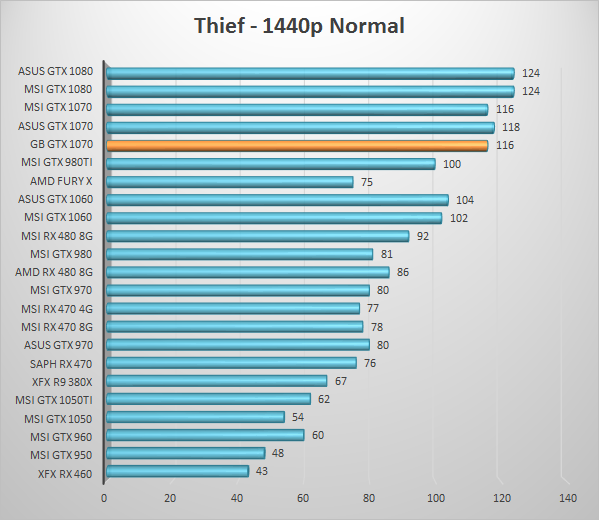

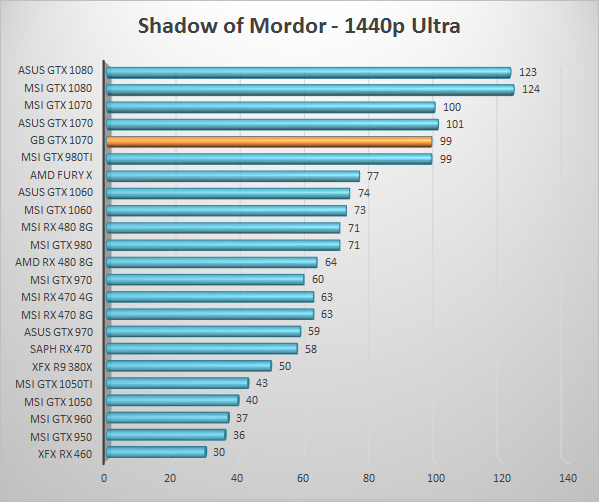

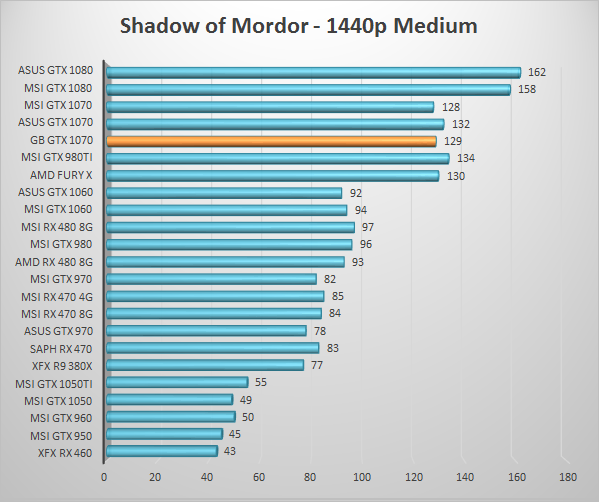

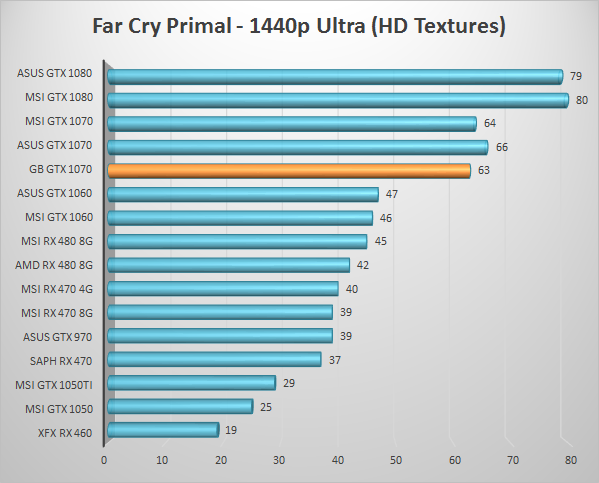

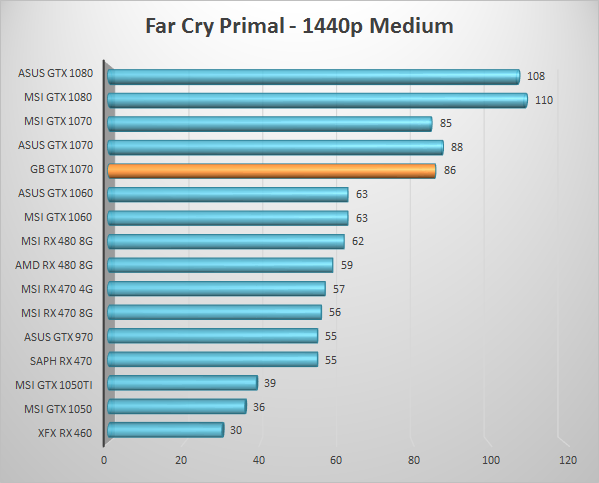

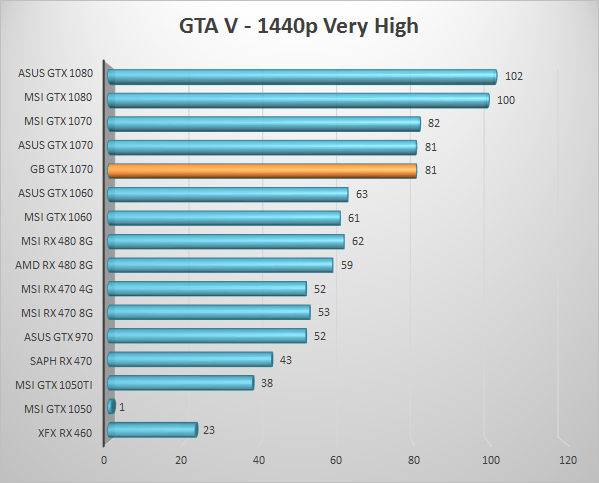

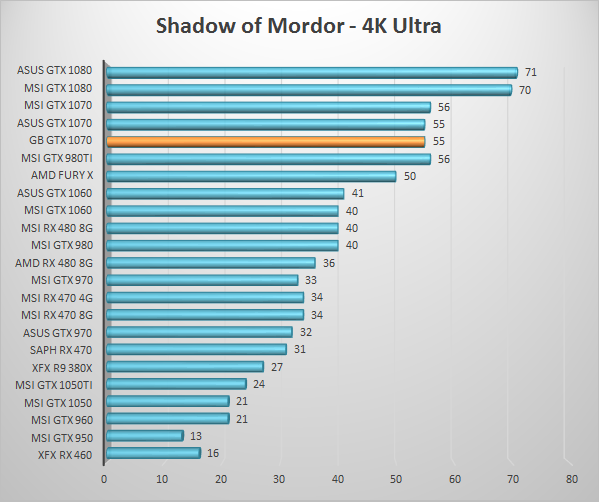

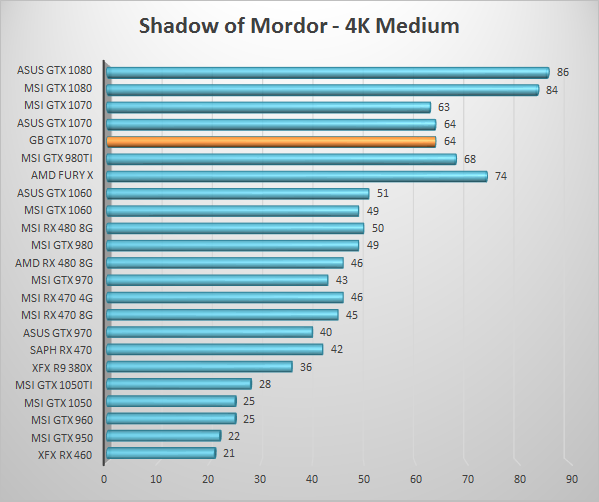

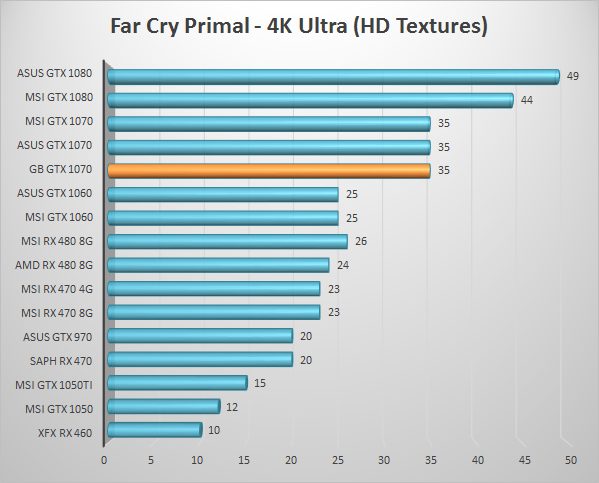

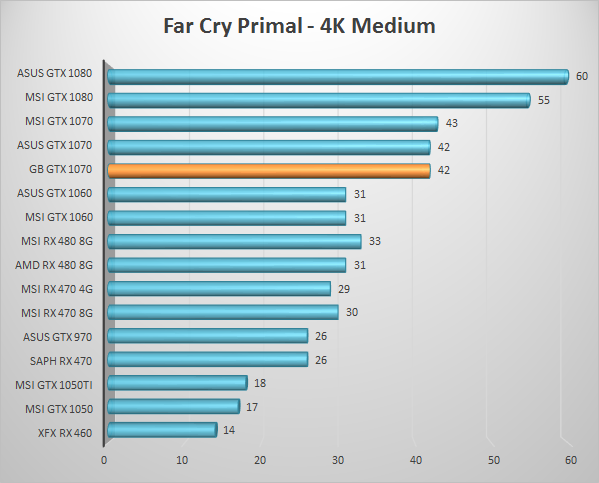

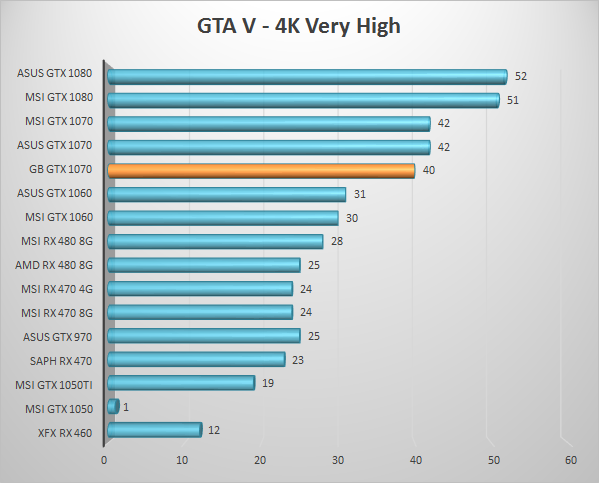

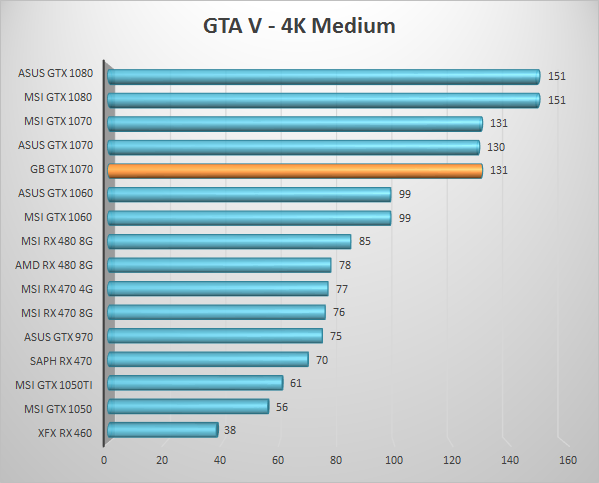

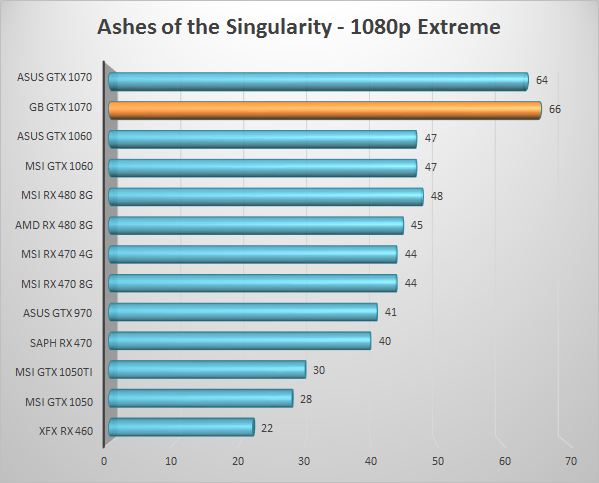

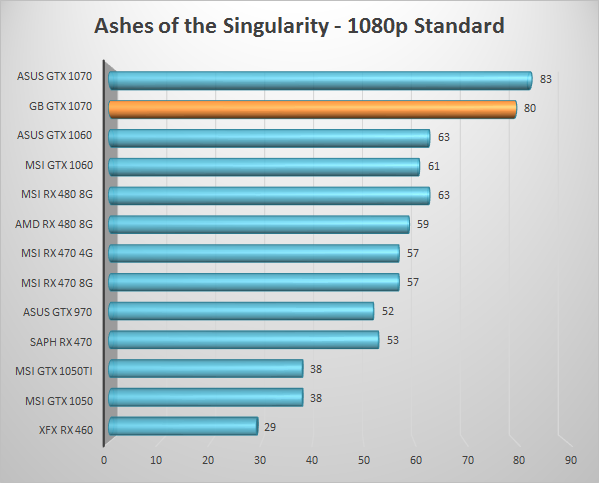

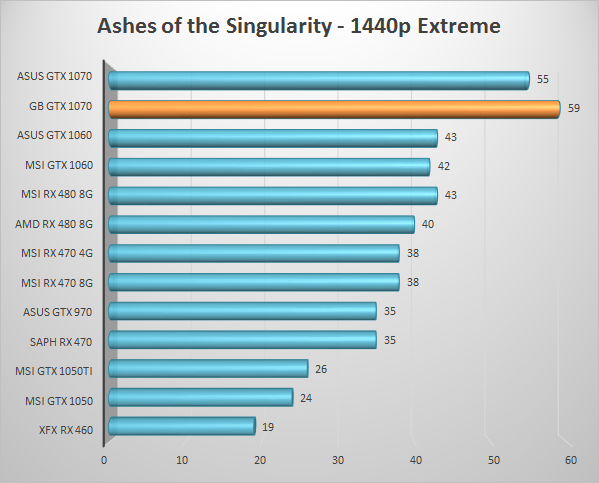

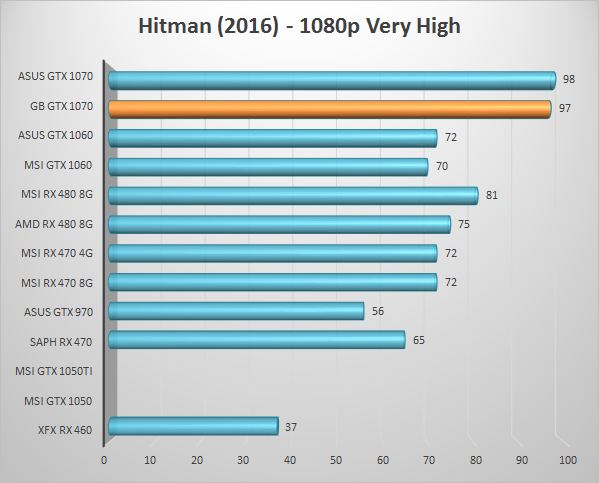

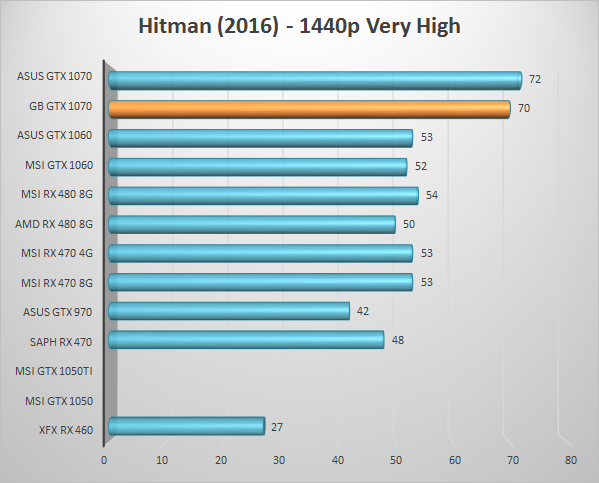

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we in de conclusie.

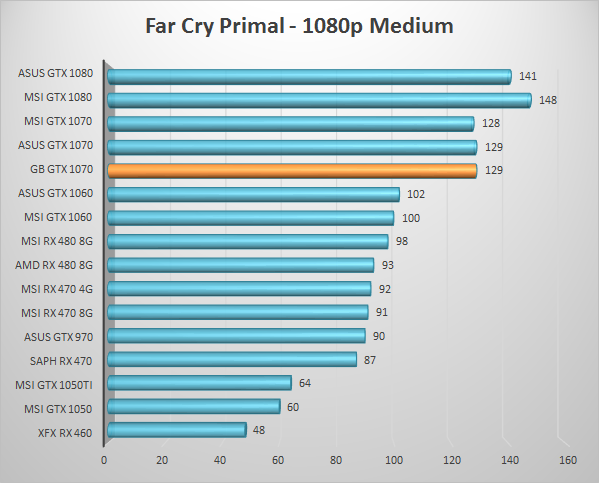

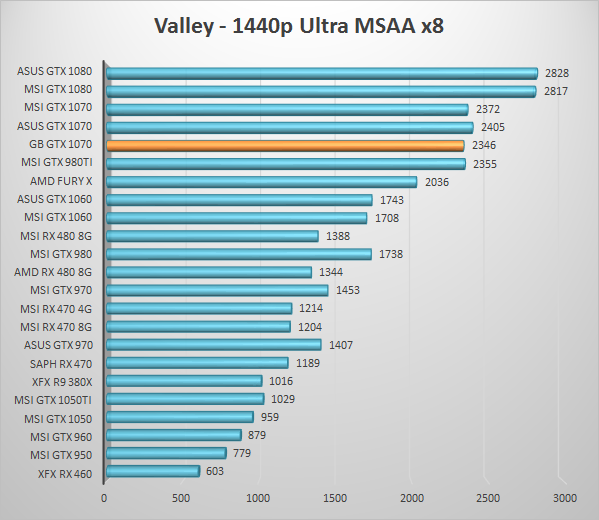

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we in de conclusie.

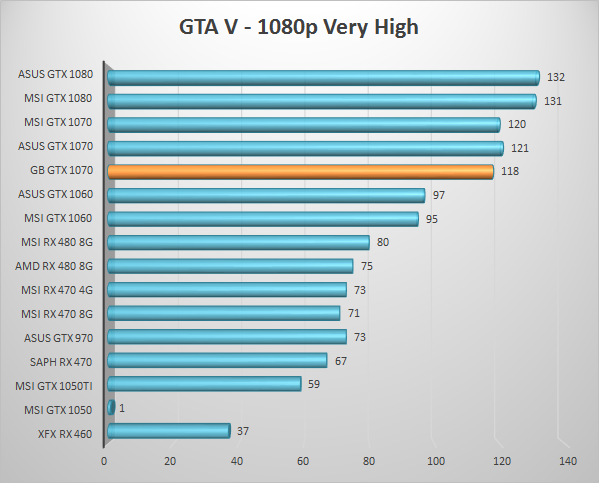

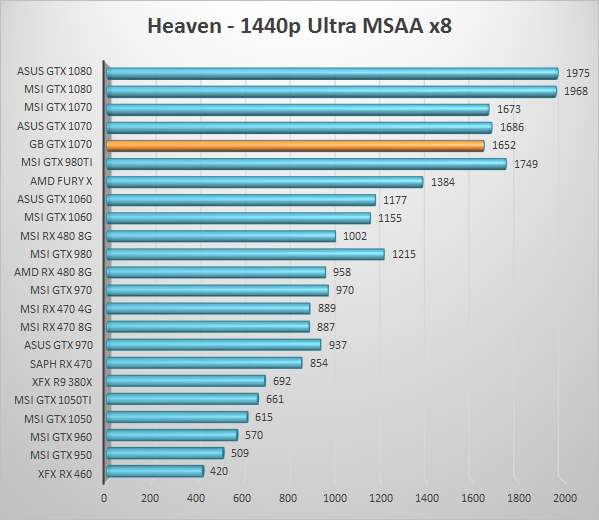

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we in de conclusie.

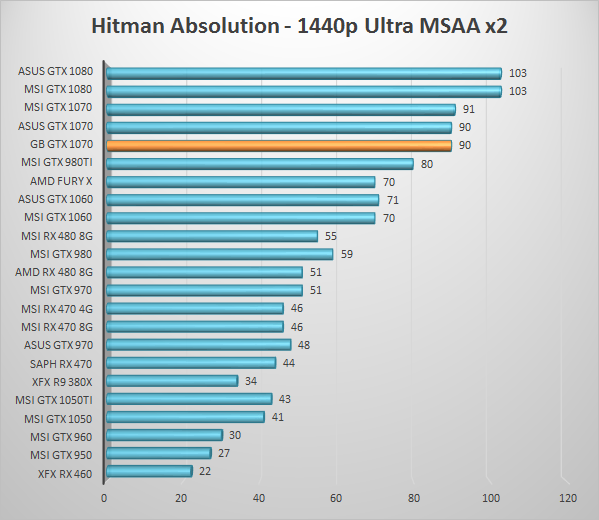

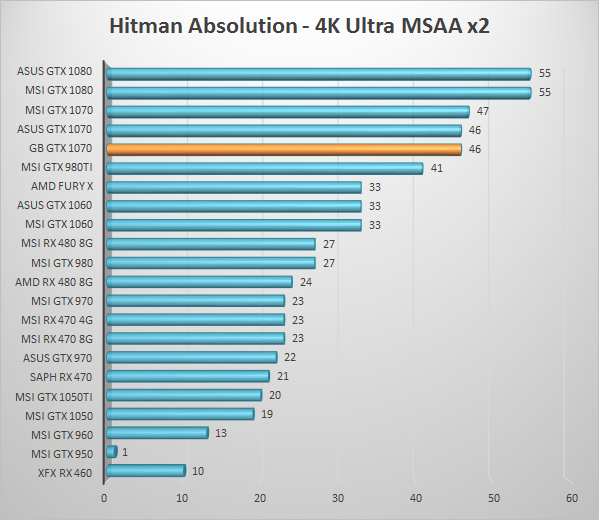

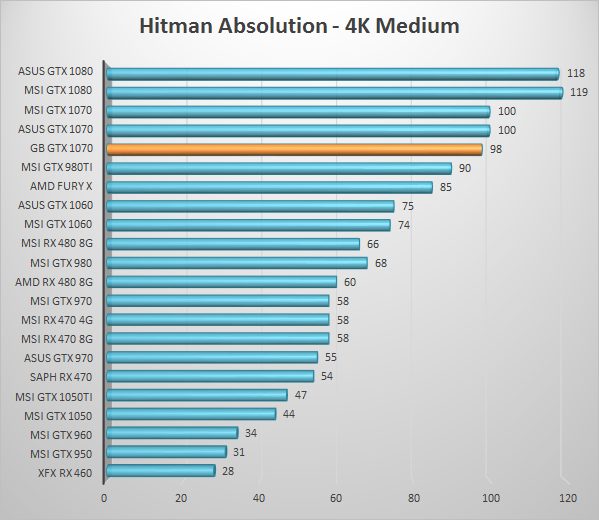

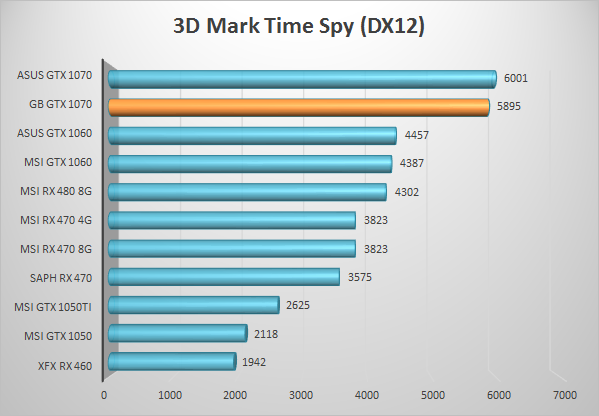

DirectX 12 is een nieuw hoofdstuk in onze GPU reviews, en zacht uitgedrukt: vooralsnog een klein drama om een goede vergelijking in te maken. Hoewel we langzamerhand meer games zien verschijnen die DX12 ondersteunen, zo ook aankondigingen zien van games die het gaan ondersteunen, is die ondersteuning lang niet altijd even goed uitgevoerd of bevat de game geen betrouwbare benchmark. Zo zien we in sommige DX12 games juist mindere prestaties bij alle GPU’s ten opzichte van DX11. Hitman (2016) is een voorbeeld van een game waarin zowel DX11 als DX12 ondersteuning zit, maar je soms wisselende resultaten ziet waarover je vervolgens weinig kan concluderen of DX12 een game nu sneller maakt of niet, daarbij hebben ze in een recente patch ook een setting-lock ingebouwd op basis van de aangesloten GPU; de Hitman 2016 Very High test kunnen we nu enkel uitvoeren op high-end GPUs; gelukkig geen punt voor deze Gigabyte GTX 1070 G1 Gaming, maar desondanks een waardeloze actie van de mensen achter Hitman.

Total War: Warhammer benchmark is een ander voorbeeld, deze start veelal niet eens op met een GTX 1070 of GTX 1080, met de GTX 1060 kon ik enkel 1080p Ultra testen en liep de 1440p Ultra test keer op keer vast. Met de GTX 1050 en GTX 1050 Ti liep hij op alle instellingen zelfs vast en daarmee wordt dit hoofdstuk nog dunner. De komende reviews zal dus nog hard gesleuteld gaan worden aan de manier waarop DX12 in GPU reviews meegenomen gaat worden.

DX12 is desondanks wel een belangrijk onderdeel om naar te kijken, want in eerder DX12 testen zien we namelijk wel degelijk interessante verschillen met de eerdere (DX11) benchmarks, en het is een redelijk veronderstelling dat DX12 meer en meer gebruikt zal worden. Daarbij is het aantal kaarten dat we in DX12 hebben kunnen testen inmiddels ook wat groter geworden, waardoor een aardig beeld geschetst kan worden.

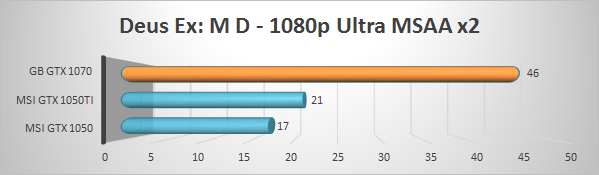

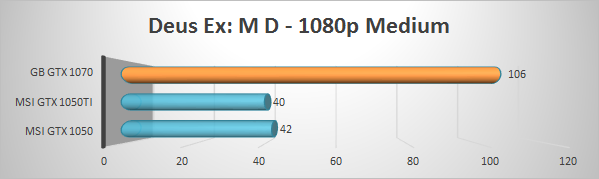

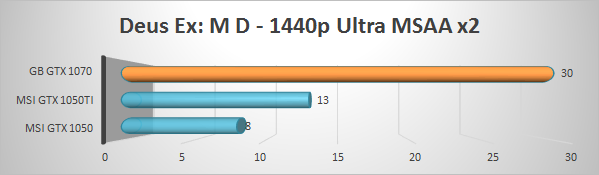

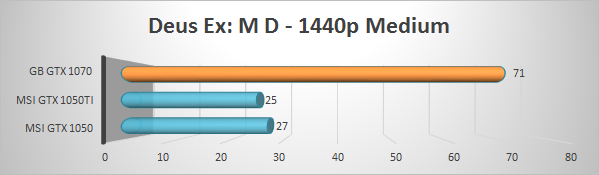

Een nieuwe benchmark! Deus Ex: Mankind Divided komt met een DX12 modus. Opvallend zware bench ook zoals je in de resultaten ziet. Spoedig meer vergelijkingsmateriaal daar, maar we zien zelfs op Full HD een GTX 1070 geen overkill zijn.

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we in de conclusie.

Ook het verbruik van een GPU is een belangrijk punt. Ik heb het verbruik gemeten bij het stopcontact, oftewel het verbruik van het gehele bovenstaande testsysteem, met een Voltcraft Energy Logger 4000. Daarnaast wordt gebruik gemaakt van een basic USB toetsenbord en een USB muis. Die verbruiken uiteraard ook een klein beetje, en op deze manier hoop ik het verbruik van een gangbaar systeem te tonen. Hoewel deze meting niet exact bepaald wat de kaart verbruikt, krijgen wij zo wel een inzicht in het daadwerkelijke verbruik van een systeem, een redelijke vergelijking van het verbruik van de verschillende kaarten, en een indicatie van wat een geschikte voeding voor een systeem in combinatie met deze GPU kan zijn (althans op gebied van vermogen).

Het verbruik wordt in drie delen gesplitst, namelijk bij:

– Het gemiddelde verbruik van de computer gedurende 10 minuten in idle (Dus niet de slaapstand, vergelijkbaar met een beetje mailen of in word/excel werken).

– Het gemiddelde verbruik gedurende de gehele Thief benchmark op Very High op 1440p (Gamen).

– Het piek-verbruik gedurende de hele benchmark sessie.

Gezien de nieuwe opstelling moesten ook deze resultaten opnieuw, hierdoor ontbreekt de grafiek terwijl wij hier hard ons best doen deze weer te vullen. Wel heb ik de MSI GTX 1070 Gaming X er weer even bijgepakt voor een directe vergelijking (die was onder load toentertijd iets zuiniger dan de ASUS Strix), en deze Gigabyte G1 Gaming komt onder load ca 6W lager uit dan de rode concurrent met een Thief gemiddelde van 289 W. Idle verbruik ontloopt elkaar dusdanig weinig, 53W voor het complete systeem met Gigabyte G1 Gaming versus 54W voor het systeem met MSI Gaming X, dat de kans op noemenswaardige besparing beperkt is, daarbij is de kans groot dat een andere sample 1W afwijkt.

Met actieve game verbruiken in de hoge 200 en pieken rond de 300W (Maximaal gemeten piek gedurende de hele sessie staat op 312W) is het nog altijd indrukwekkend hoe veel prestaties Nvidia uit dusdanig weinig verbruik weet te pushen. Ik blijf erbij dat het feitelijk fenomenaal is wat Nvidia heeft bereikt op gebied van efficiëntie de laatste generatie. Grote stap van AMD met Polaris terzijde: Nvidia pakt hier duidelijk de kroon.

Voedingsadvies of keuze wordt er ook eenvoudiger op. Feitelijk zal elke degelijke merk voeding met de benodigde 8-pin PCIe aansluiting voldoen, en dan zit je per definitie (op enkele zeldzame uitzondingen na) al in de 350+ W categorie. Voor SLI heb je in feite voldoende door er 200W bij te tikken, al kan het lonen om iets ruimer te gaan als je tevens intensief wilt overclocken. Maar ook met een GTX 1070 in SLI is er zelden reden voor meer dan een degelijke 650W voeding. Daarmee is een moderne SLI gebruiker veelal nog zuiniger dan een semi-fanatieke gamer 6 jaar geleden.

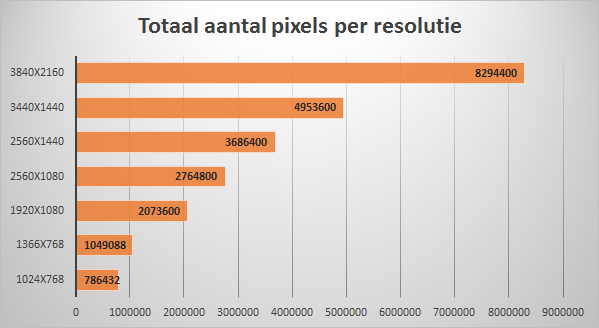

Om andere resoluties te bespreken eerst de grafiek met het aantal pixels per resolutie:

Voor zij die een minder gebruikelijke resolutie scherm hebben en de resultaten in perspectief willen zetten kan het bovenstaande plaatje helpen. Helemaal 1:1 schalen prestaties niet met de hoeveelheid pixels van je monitor, maar veel ontloopt het elkaar niet. We kunnen met de GTX 1070 resultaten concluderen dat het een top (zij het ietwat overkill) kaart is voor 1080p gaming, dat 1440p panelen een sweet spot zijn waarbij de prestaties goed tot hun recht komen en hoge instellingen kunnen voorschotelen (zij het af en toe wellicht net een extreem detail minder), maar dat 4K dusdanig zwaar is dat je eigenlijk meer wilt; maar goed zelfs een GTX 1080 krijgt het daar veelal zwaar te verduren.

2560×1080 eigenaren hoeven zich geen zorgen te maken. 3440x1440p eigenaren zullen met hun extra breedte wel af en toe concessies moeten doen op de beeldkwaliteit, maar de GTX 1070 heeft vaker dan niet prestaties over om de instellingen hoog te houden. Hoewel een GTX 1080 hier ook tot zijn recht zou komen blijft de prijs-prestatieverhouding ook bij de ultrawide 1440p panelen uitstekend.

Ik zal wederom moeten herhalen dat de Nvidia GeForce GTX 1070 in mijn mening een bijzonder interessante chip is. De GTX 1080 mag dan wel sneller zijn, maar dat verschil staat niet in verhouding tot de meerprijs terwijl de meer-prestaties van de GTX 1070 boven de GTX 1060 en RX 480 overtuigend zijn, zeker voor gamers met een 1440p of andere voorbij-1080p resolutie kan je die prestaties veelal goed gebruiken, of in elk geval op korte termijn. Verschillen tussen DX11 en DX12 zijn verder ook niet zo relevant wanneer je ziet dat deze chip feitelijk alleen staat in de midden-hoge klasse. De chip biedt, gebrek aan concurrentie terzijde, simpelweg een mooie balans tussen toch-heel-erg-veel prestaties en een prijs die natuurlijk nog altijd wel flink genoemd mag worden, maar waarbij ik het woord ‘duur’ absoluut niet kan gebruiken. Dat laatste is zeker het geval wanneer je ziet dat de wat voordeligere GTX 1070 modellen, zoals deze Gigabyte G1 Gaming flinke druk uitoefenen op de luxere GTX 1060 uitvoeringen, met soms maar enkele tientjes verschil. Wat ook op de nog luxere kaarten drukt is het feit dat alle 1070’s -die ik tot nu toe tegen ben gekomen- zo rond de 2100MHz tegen hun beperkingen aan lopen; het overclocken van de duurdere kaarten was zodoende niet interessanter dan betaalbare modellen als dit, en je kan je vrijwel geheel richten op zaken zoals uitstraling, koel- en geluidsprestaties, of eventuele unieke features.

Kijken we wat de Gigabyte GeForce GTX 1070 G1 Gaming te bieden heeft dan zie ik vooral positieve opmerkingen wat betreft de prijs-prestatieverhouding. Eerst even het cruciale bij de prestaties: ASUS en MSI zetten hun kaarten voor reviewers direct in de OC stand wat ze net dat zetje in de grafieken geeft waardoor ze gemiddeld nipt aan beter lijken, Gigabyte doet dat (in ons geval althans) niet. Dat kleine verschil wat je in de grafieken ziet is al praktisch niet te merken, en met een handmatige activatie van de OC modus zoals een consument bij de twee geteste concurrenten ook moet doen trek je dat ook wel weer recht. Conclusie: je zal in de praktijk puur op basis van FPS prestaties de verschillen niet waarnemen tussen de drie 1070’s in de grafiek.

Ook niet onbelangrijk, de Gigabyte G1 Gaming is een hele toffe uitvoering voor nauwelijks meer knaken dan de instap-GTX1070’s. Het is een kaart die desondanks zeker aantrekkelijk is vormgegeven, nette stevige kappen heeft en keurig is afgewerkt, en een uitstraling biedt die zich vooral ook uitstekend zal laten combineren met andere hardware. Hij is verder voorzien van de praktisch fijne features zoals RGB LEDs en stilstaande ventilatoren, en een mooie balans biedt tussen ‘die dikke GPU look’ en toch bruikbare totale afmetingen; niet overdreven lang, en niet breder dan gebruikelijk wat Gigabyte een streepje voor geeft voor gebruikers met smallere kasten. Het enige waar Gigabyte echt wat aan moet doen is de uitstraling en feel van de software, die is gevoelsmatig ergens vorig decennia blijven steken, maar hij werkt gewoon naar behoren en biedt ook de voor de hand liggende manual overclock features waarvoor je elders soms weer meer software moet installeren; inhoudelijk betreft dus niet verkeerd. Het feit dat er zonder al te veel moeite met een auto overclock feature en wat eenvoudige sliders ook nog hogere scores gehaald kunnen worden is natuurlijk ook fijn; 6-7% FPS boost in mijn korte OC sessie is prima.

Hoewel de koeloplossing objectief vergeleken niet de ultieme prestatie neerzet wat betreft graden Celcius versus Decibellen ben ik nog altijd van de praktische beoordeling: 37dBA op volle belasting met overclock op 30cm van een NZXT S340 Elite, verre van de meest dempende case, is gewoon een praktisch keurig resultaat en zorgt voor een game pc die zelfs tijdens gamen nauwelijks te horen is, laat staan zal storen. Zeker voor zij die upgraden van een paar generaties terug waar een flink hogere geluidsproductie de norm was. Het is echter wel de GPU die dat beetje geluid veroorzaakt in die build, dus het mag hem desondanks wel worden aangerekend. Ik blijf van mening dat Gigabyte, net als Asus die eveneens een erg agressief fanprofiel gebruiken, er verstandig aan doet om de maximale geluidsproductie nog iets te laten zakken ten koste van een paar graden zodat je over een echt onhoorbare kaart kan spreken; dat is handig voor open test benches, minder gedempte systemen en voor mensen gevoelige oren en de koelprestaties zijn verder dusdanig dat dat ook gewoon kan. Gelukkig is dat ook iets wat je eenvoudig zelf naar eigen wens kan aanpassen in de software, iets wat ik dan ook aan zou raden voor echte stilte liefhebbers.

Het is een beetje Hollands om weer terug te komen op de prijs, maar deze Gigabyte GeForce GTX 1070 G1 Gaming heeft de prijs nu eenmaal in z’n voordeel en wanneer er dozijnen uitvoeringen op de markt zijn mag dat punt gewoon wegen. Op moment van schrijven zo’n 75 euro voordeel ten opzichte van de Asus ROG Strix OC wat toch bijzonder zwaar weegt op de totale balans tussen die twee kaarten, waarbij elementen zoals een wat luxere LED uitvoering daar dan geen eenvoudige ‘sell’ zijn. De MSI Gaming X is objectief dan een wat pittigere kluif voor deze Gigabyte G1 Gaming met zijn lagere geluidsproductie bij zware belasting, maar ook een paar tientjes in het voordeel van de Gigabyte zullen in het oog van de consument gewogen worden. Daarbij biedt Gigabyte dus nog altijd een net totaalplaatje en zeker ten opzichte van de dominant rode concurrent toch ook een flink breder inzetbaar product dan enkel bij zwart/rode builds.

Al met al dus een keurig totaalplaatje –plus- een lekker prettig prijskaartje, en zodoende weet de Gigaybyte GeForce GTX 1070 G1 Gaming onze warme aanbeveling dan ook zeker te verdienen –en- is het een slimme keuze voor zeer prijsbewuste GTX 1070 kopers.

Nog enkele vergrotingen, klikken voor vol formaat:

[wpdevart_facebook_comment curent_url=”http://www.techtesters.eu/gigabyte-gtx-1070-g1-gaming-review/” title_text=”” order_type=”social” title_text_color=”#000000″ title_text_font_size=”1″ title_text_font_famely=”arial” title_text_position=”left” width=”100%” bg_color=”#d4d4d4″ animation_effect=”random” count_of_comments=”10″ ]