AMD Radeon RX Vega 64 review

2017 lijkt toch een bijzonder jaar voor AMD; enkele maanden geleden waren ze spontaan terug van (praktisch toch) weggeweest in de processormarkt, nog maar enkele dagen geleden opende ze het door Intel gedomineerde high-end consumerplatform van Intel, en vandaag, na weliswaar eventjes (understatements 4tw) wachten en best veel spanning, is het eindelijk tijd om de nieuwe topchip van AMD op gebied van graphics te bekijken: De AMD Radeon RX Vega 64.

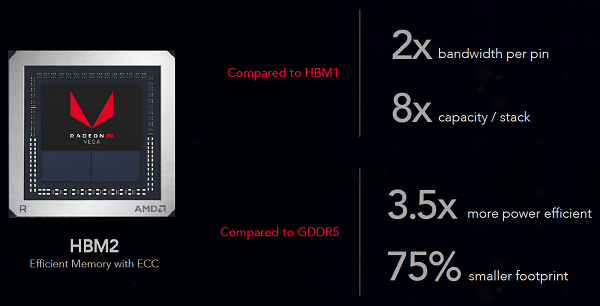

Een nieuwe architectuur, gebruik van HBM2 geheugen, en nog hogere kloksnelheden dan we eerder zagen van AMD maken het verschil ten opzichte van de RX 570 en RX 580 producten. Die waren weliswaar interessant voor het grote publiek, maar voor wie echt wat meer GPU power wilde, of eigenlijk voor wie serieus wilde gamen op voorbij Full HD / 1080p resolutie, was het wachten op Vega.

Zoals altijd met deze gloedje nieuwe chips zijn er nog wat onduidelijkheden. Zo is het nog gissen wat de daadwerkelijke straatprijs gaat zijn zodra de kaarten goed beschikbaar komen, welke fabrikanten met welke custom varianten gaan komen, en uiteraard in hoeverre er nog geoptimaliseerd gaat worden. In de komende weken zullen we vast talvan Vega kaarten tegen gaan komen, maar we gaan toch echt niet wachten om lekker aan de slag te gaan met de Radeon Vega 64 Black editie, oftewel het referentiemodel die hier voor ons ligt.

De meeste presentatieslides en details stonden tot moment van publiceren onder embargo, en zijn dus ook enkel met grote watermerken beschikbaar. Zodra ik de versie heb zonder dat je constant in mega letters mijn e-mail adres door je mik gedrukt krijgt voeg ik de betreffende slides hieronder toe.

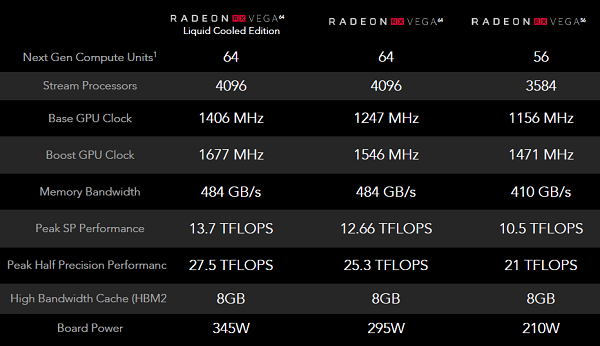

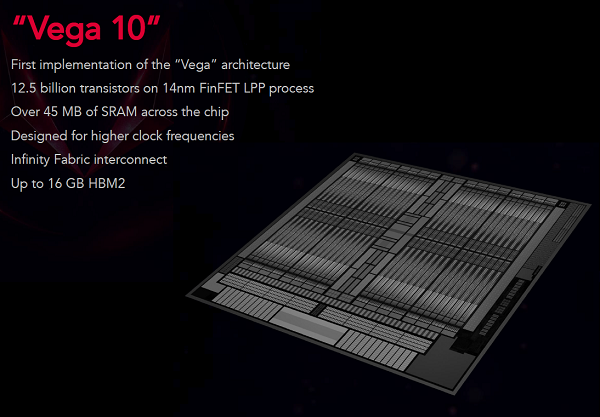

Een aantal zaken waren echter al geen verrassing meer: De Vega 64 is een 64 Compute unit, 4096 Stream processor GPU met een redelijk bescheiden standaard klok en een flinke boost zoals we de laatste jaren gewend zijn geraakt. Opvallend uiteraard de overstap van GDDR5 en GDDR5X naar HBM2 geheugen; sneller, zuiniger, compacter. Als 295W TDP bord zien we straks ook twee 8-pin PCI-e power aansluitingen, al is het niet ondenkbaar dat we 8+6 pin modellen of juist nog extremere modellen gaan aantreffen. Zo zien we namelijk al een ruimere instelling op de watergekoelde uitvoering (misschien zien we die nog eens), maar ook een Vega 56 variant met een toch ruim lager TDP in verhouding tot het aantal compute units. Zoals je in de slides ook ziet (of zal zien) brengt een nieuwe architectuur natuurlijk de nodige (veelal bekende) voordelen mee: sneller, krachtiger, efficiënter, voer voor geeks (en er zullen vast voldoende technische verhalen volgen) maar met handen gebonden en een drukke week gaan wij ons vooral richten op het resultaat.

Ten opzichte van vorige architectuur releases is de directe focus erop ietwat beperkt. Voor zij die de reviews van de Radeon Vega Frontier Edition, de Vega gericht op compute taken maar door sommigen al redelijk ‘geprobed’ als game kaart, zal dat wellicht ook geen hele grote verrassing zijn. De kans dat AMD echt tegengas ging kunnen geven aan de huidige top van Nvidia zoals de GTX 1080 Ti, leek namelijk vrij klein, iets wat de hier en daar genoemde prijzen (400 tot 600 euro) voor deze kaarten ook lijken te vermoeden. Hoewel we het verder niet over de Frontier Edition gaan hebben brengt het wel een relevant discussiepunt mee, want het geeft aan dat de Vega chip op zich al best even klaar is, en dat AMD ruim tijd heeft gehad voor driveroptimalisaties voor games en dergelijke. Enerzijds verwachten we altijd nog verbeteringen en optimalisaties, maar anderzijds zien we redenen dat ze dar dus best al ver mee zouden moeten zijn.

In plaats van een eindeloos verhaal over hoe veel beter, sneller, of wat dan ook Vega is, zien we juist een enorme focus op Freesync vanuit AMD. Dat zagen we in de vroege communicatie al, maar het gaat verder: webshops die directe AMD partner zijn zullen de Vega kaarten met combi kortingen aan gaan bieden waarbij je flinke kortingen krijgt op Freesync schermen en games bij aanschaf van een Vega. Vermoedelijk deels om Freesync te pushen en Vega nog interessanter te maken, en de genoemde kortingen oplopend tot 200 euro op een scherm zijn zeker geen kattepis, maar het zou ook een verdedigingsmechanisme kunnen zijn tegen de altcoin miners die alle recente AMD kaarten hebben opgekocht; een ietwat hoge prijs compenseren met dikke kortingen op schermen en games dus. Normaliter zouden binnen Nederland Alternate en Azerty de grote AMD partners zijn zijn, echter lijken die vooralsnog geen onderdeel van die pakketten. Wees er in elk geval even alert op de komende dagen als je in de markt bent voor een nieuwe GPU en monitor.

De Freesync focus is echter wel een begrijpelijke, en zij die onze RX 570 en RX 580 reviews hebben gelezen weten ook dat wij dat in de spannende strijd tussen die chips en de GeForce GTX 1060 toch ook echt de primaire onderscheidende feature vinden. Zowel Freesync als Nvidia G-Sync zijn inmiddels bewezen, overtuigende technieken om je game ervaring soepeler te maken zeker zodra je grafische kaart het zwaar krijgt. Speel je je vlotte games op 60+ fps, of als je gevoelig bent nog iets hoger, dan zal je er niet direct veel van merken. Echter speel je een redelijk vlotte game op hoge resolutie met een niet-top-end kaart en zie je constant 35-55 fps, dan zal je niet heel getalenteerd hoeven te zijn om daar wat haperingen in te voelen. Beide sync technieken pakken dat probleem uitstekend aan en zorgen bij dergelijke prestaties dat de game wel degelijk soepel voelt. Like magic, that works. Concreet: 40-45 FPS met Freesync of G-sync voelt dan veelal beter dan 50-55 FPS zonder, een gat dat klein klinkt maar waarvan we niet moeten vergeten dat een dergelijk gat overeenkomt met een klasse duurdere grafische kaart.

Hoewel je zou denken dat een high-end GPU koper, veelal liefhebbers van hoge FPS waardes denken we, daar geen boodschap aan heeft is de realiteit anders. Gamen op 3440x1440p schermen of 4K schermen is zelfs met alle denkbare kracht van vandaag geen kinderspel, en er zijn genoeg games waarbij ‘Ultra’ en 60 fps+ op die resolutie simpelweg ondenkbaar is, en Free- en G-Sync dus wel echt potentie hebben.

Hoewel beide kanten graag vertellen dat hun techniek inhoudelijk beter is is het in de praktijk niet iets waar je stil bij hoeft te staan. De verschillen zitten namelijk niet in het resultaat, maar in de keuzevrijheid en uitvoering. G-sync heeft als voordeel dat Nvidia de teugels strak in handen heeft, en een G-Sync scherm per definitie aan redelijk strenge eisen voldoet; staat er G-Sync op het scherm dan hoef je feitelijk niet verder te kijken. Freesync, of Adaptive Sync, kan een fabrikant zelf implementeren zonder extra ‘module’ van Nvidia, AMD of andere partij. Het directe voordeel is vrij simpel: kosten, het scheelt je al snel 100 a 200 euro tussen vergelijkbare modellen met Freesync of juist G-sync. Het bijkomende voordeel: We zien Freesync dan ook in veel- en veel meer schermen terug, ook in tal van schermen die primair weliswaar niet op gamers richten, maar met Freesync toch interessanter zijn voor werkers of creatieve types die ook een game wens hebben. Een nadeel is er ook, en dat is dat de implementatie van Freesync in lang niet alle monitoren echt aantrekkelijk is gedaan. Zo zien we soms schermen die onder de 55Hz geen Freesync kunnen toepassen, terwijl juist daar de grootste winst zit.

Even opletten bij je Freesync monitor aanschaf dus om teleurstellingen te voorkomen. Maar zelfs als je daar strengere eisen aan stelt blijft het aanbod duidelijk groter, en blijft het prijsverschil overduidelijk in tact. Reden genoeg voor ons om te stellen dat Freesync op dit moment, en tot zover wij kunnen zien in de komende jaren, de aantrekkelijkere techniek is voor een veel grotere doelgroep, terwijl G-Sync voorbehouden lijkt aan zij die danwel een echt groen hart hebben, of gewoon niet kijken of een paar honderd euro meer of minder voor hun ultieme monitor aanschaf. 100-200 euro lijkt wel veel op een typische monitor (Sorry: “is best veel”), kijken we naar de absolute top panelen die de 1000 euro ruim overstijgen dan is het niet heel vreemd dat we fabrikanten daar toch frequent zien kiezen om toch voor de G-sync module te gaan. In pure aantallen is Freesync wel groter, maar kijken we naar de aller dikste pure gaming schermen dan is G-Sync daar toch erg sterk vertegenwoordigd, vermoedelijk ook vanwege de recente dominantie van Nvidia in het top-end segment van GPUs.

Een feature die voor een grote doelgroep, monitor irrelevant, interessant is is de Enhanced sync optie. Vergelijkbaar in effect met Nvidia Fast Sync, is een alternatieve V-Sync implementatie die praktisch het gehele voordeel van V-Sync on verzorgd, maar dan zonder (of zonder het grootste deel) van de vertraging die V-Sync met zich meebrengt. Voor de aller aller snelste games, ik denk bijvoorbeeld aan CS:GO, blijf ik fan van V-Sync off. Maar het is zeker een optie om even mee te stoeien, grote kans dat je Enhanced Sync namelijk kan waarderen.

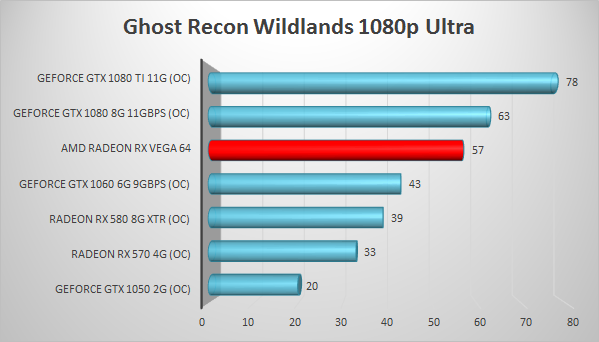

Andere focuspunten hebben we ook eerder gezien van AMD. VR uiteraard, iets wat wij echter niet kunnen testen, en Radeon Chill / Frame Rate Target control, de optie om je GPU het rustiger aan te laten doen wanneer een game dermate licht is dat die enorme FPS waardes niet tot hun recht komen. Het resultaat; minder verbruik, en dus minder geluidsproductie. Leuk, maar we willen nu toch vooral zien wat de chip in huis heeft. Iets vergelijkbaars kan ik zeggen over HBBC, de optie om je werkgeheugen in te zetten als extra VRAM geheugen voor wanneer die 8GB een keer tekort schiet. Voorlopig zal het niet zijn, sterker nog ik kom zelfs in de zwaarste bench (Wildlands, 4K, Ultra) niet in de buurt, maar het zit er in elk geval in.

Emoties bij het aannemen van het pakketje: buigen, kwijlen, spannend, bijna laten vallen van spanning, en nog wat kwijlen. Flinke doos, nog wat spanning, en…

Natuurlijk gaat het om het product, maar de manier waarop je op deze manier naar je product toewerkt dat voelt toch wel verdomd goed. Zo’n simpele glazen kubus kan je in een souvenirshop natuurlijk halen met tal van dingen erin, maar om je Vega kubusje naast je pc te hebben is toch leuk?

Verder zien we een armbandje, wat stickers, en best opvallend: een dummy GPU om te aanschouwen. Let op: ik neem aan dat deze ook in de retail variant gaat zitten, maar hou even een slag om de arm.

De Vega kaart zelf zit ook weer in z’n eigen doosje, en dan kunnen we eindelijk een beetje genieten.

Voor de goede orde: ik was in de veronderstelling dat dit de retail verpakking was, was niet geïnformeerd over eventuele specifieke review verpakkingen. Echter zal de verkoop van Radeon RV Vega kaarten uiteindelijk via hun board partners verlopen, en het lijkt best aannemelijk dat de Asus / MSI / Gigabytes / etc van deze wereld geen mega dozen gaan verschepen met kubusjes en dergelijke erin. Om teleurstellingen te voorkomen, hou een slag om de arm.

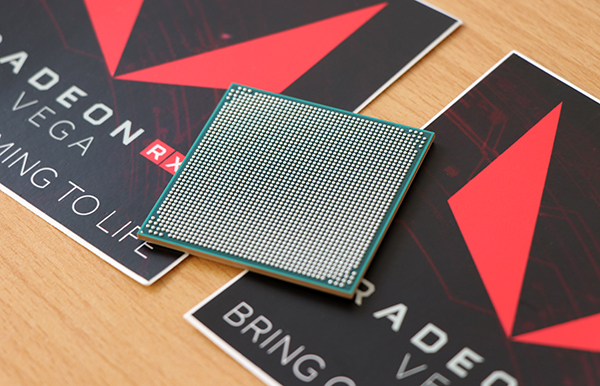

Natuurlijk draait het eigenlijk om de onderliggende chip, en daar komt ook het sterke sentiment rondom dit pakketje vandaan. Heel droog bekeken is de blower-stijl referentiekoeler natuurlijk niet heel anders dan wat we eerder hebben gezien; lekker zwart, keurig degelijk, weinig poespas maar toch met wat strakkere details wanneer we inzoomen. We doen ons rondje, wat toch ook best leuke plaatjes oplevert.

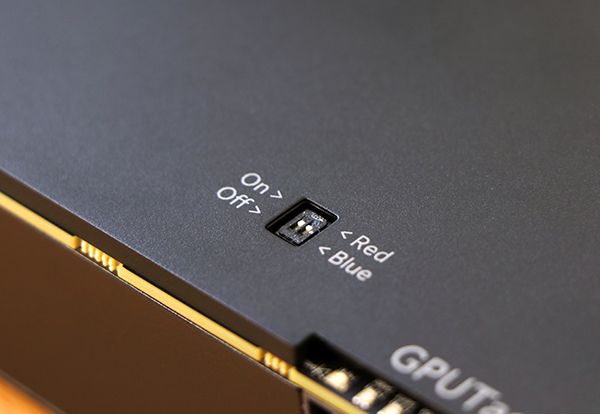

De volledige backplate is wel een welcome toevoeging, oogt allemaal net wat strakker. En ook de workload-LEDjes boven de aansluitingen die we eerder op de Fury X zagen zijn weer van de partij. Deze kunnen naar gelieve worden uitgeschakeld, of blauw in plaats van rood oplichten.

Aansluitingen komen in de vorm van drie DisplayPort aansluitingen en een enkele HDMI out, uiteraard met 2.0 / 60 Hz op 4K support.

De testopstelling bestaat momenteel uit een Intel Core i7-6700K met 16GB DDR4.

Alle kaarten worden getest met de instellingen zoals ze uit de fabriek komen, fabrieks-overklok instellingen blijven dus in tact. Verder overklokken en eventueel resultaten die daarbij van toepassing zijn worden in de individuele reviews onder de header “overklokken” besproken. Alle benchmarks zijn om uitschieters te voorkomen meerdere malen uitgevoerd, waarbij opvallende uitschieters worden gefilterd en het gemiddelde wordt weergegeven.

Een belangrijke opmerking met betrekking tot de drivers. Driver updates geven soms wat prestatieverbeteringen, maar veelal in specifieke games. Een vergelijking maken met een oudere kaart op oudere drivers is dan ook niet altijd 100% eerlijk. Anderzijds mag je bij een gloednieuwe chip verwachten dat er nog optimalisaties in de pipeline zitten. De meeste games in deze vergelijking zijn wel al eventjes uit, dus de kans dat een nieuwe driver verder geoptimaliseerd is voor die game is dan zeer klein bij een iets oudere chipset, maar er blijven wat onvermijdelijke risico’s aan zitten.

Alle games in onze GPU reviews hebben een geïntegreerde benchmark. Dit zorgt voor een eerlijke vergelijking tussen de kaarten per game, de gebruikte instelling staat in de header van elke grafiek.

Ok, niet het testsysteem, maar we willen natuurlijk wel zien hoe die kaart er in de praktijk uit zou kunnen zien. Hop hop, in de NZXT Noctis ROG met de nodige aankleding: NZXT Kraken X52, NZXT Aer fans, dik Z270 Maximus Code moederbord, the works.

Wel onderdeel van de test opstelling, de Seasonic Prime. Tijdelijk even meeverhuisd naar die setup mochten de eerder gelekte, onwaarschijnlijke, verbruikswaardes toch werkelijkheid blijken kan ik de meer bescheiden bemeten voeding van vrouwlief haar machine in elk geval niet beschadigen.

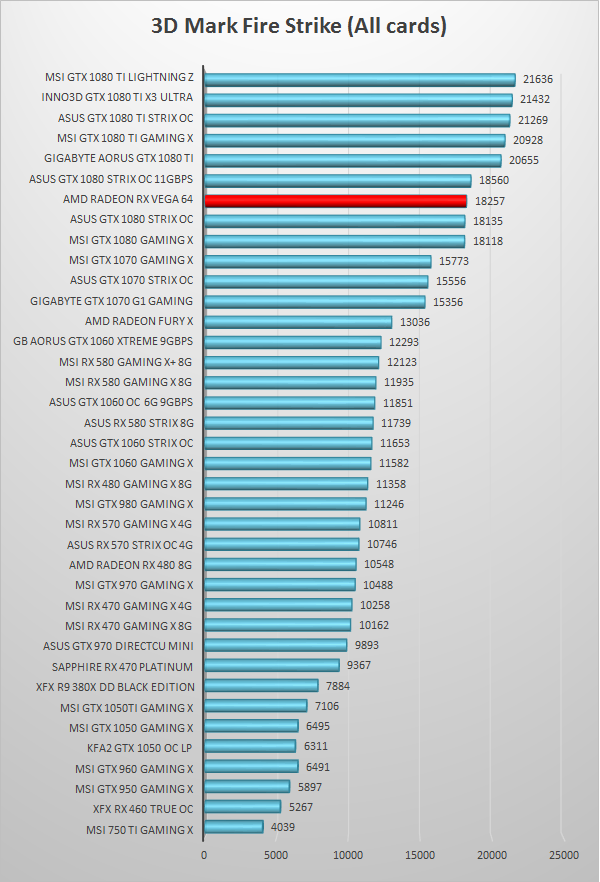

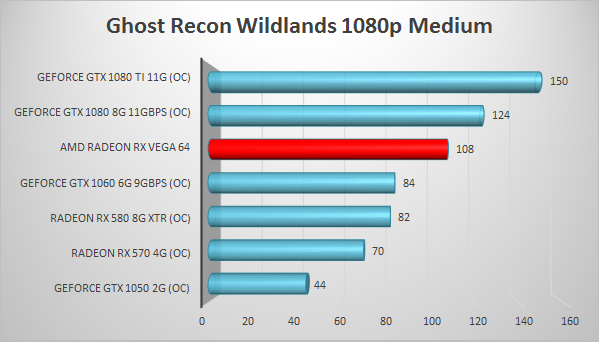

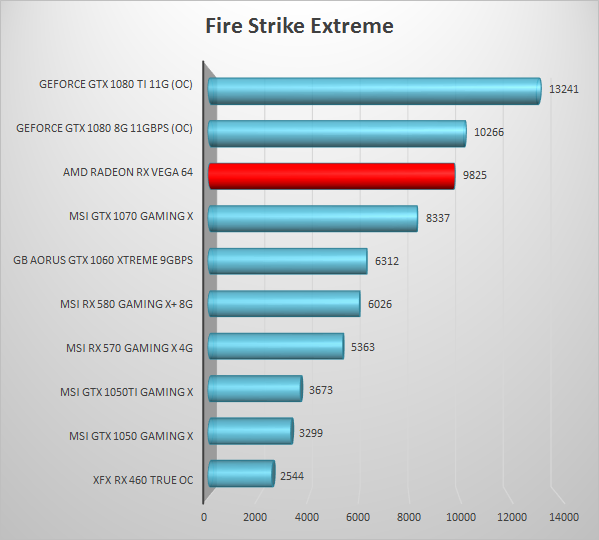

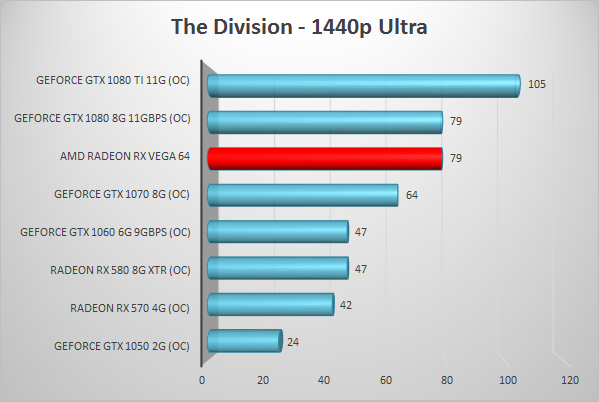

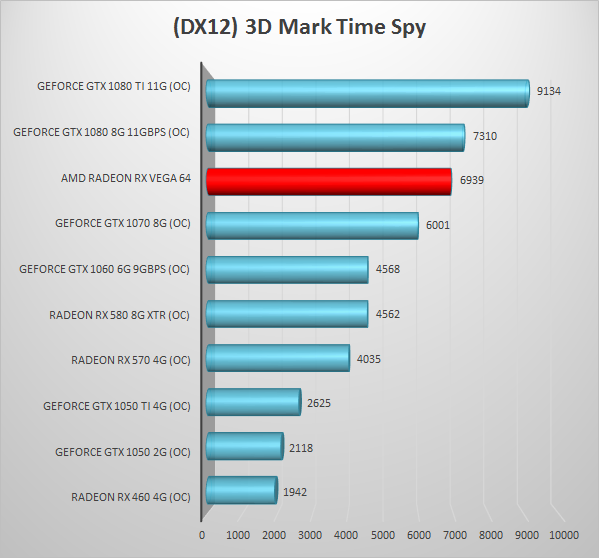

Laten we beginnen met toch wel de grote single GPU benchmark: 3D Mark FireStrike. Deze resultaten zijn nog altijd representatief voor onderlinge krachtverschillen en deze ranking pinnen we dan ook vast in alle onderstaande grafieken: zo zie je de directe concurrenten consequent direct naast de kaart in test.

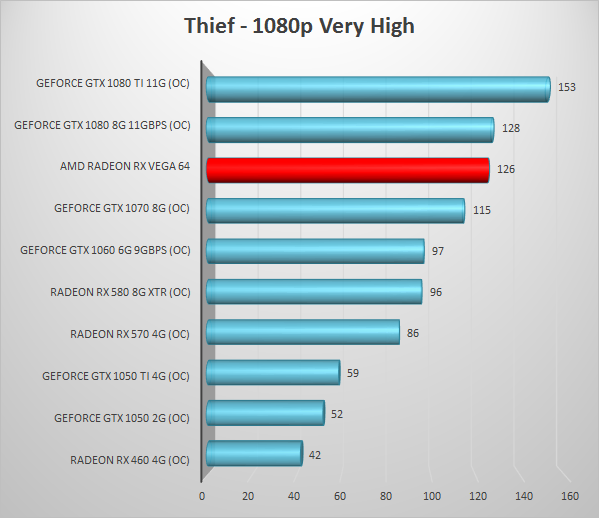

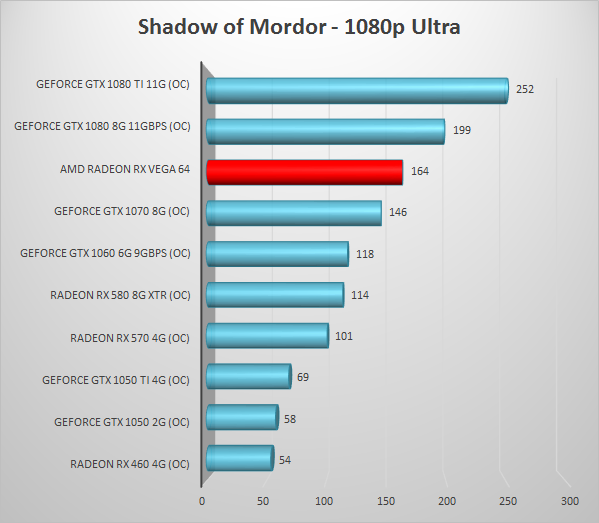

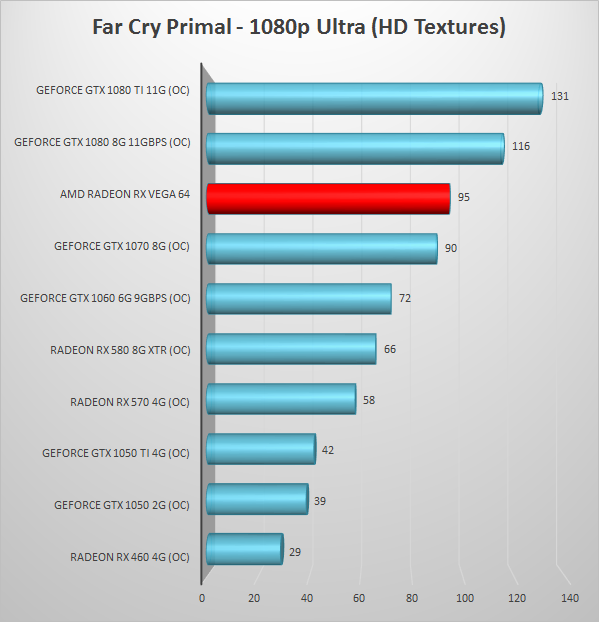

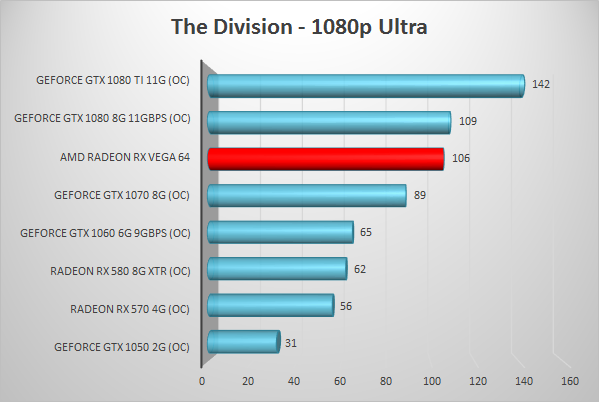

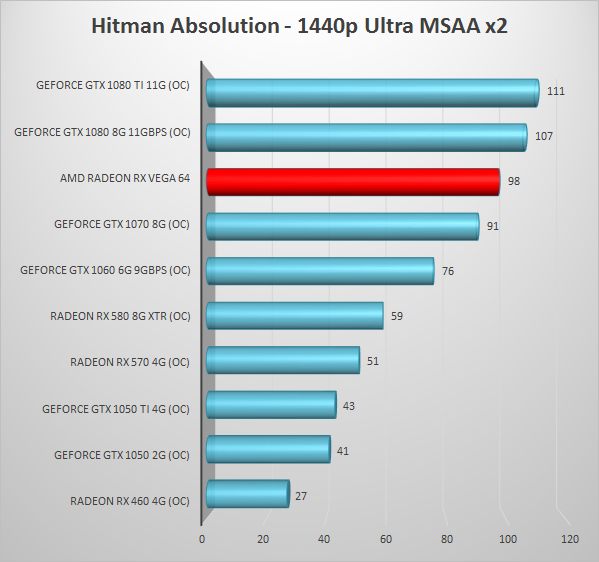

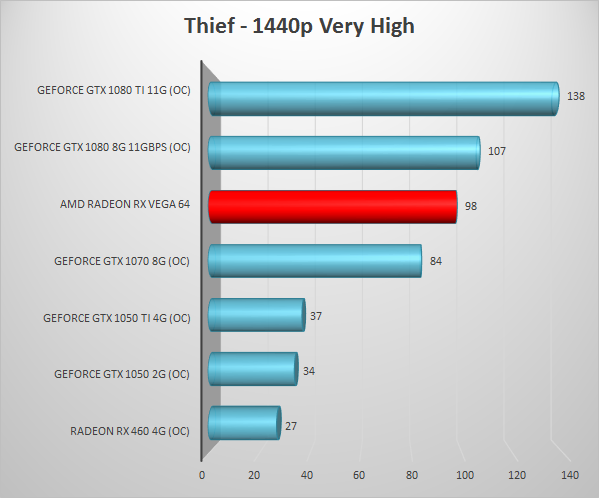

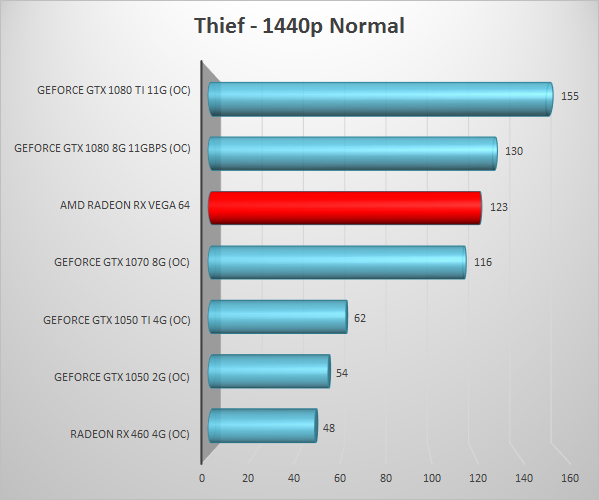

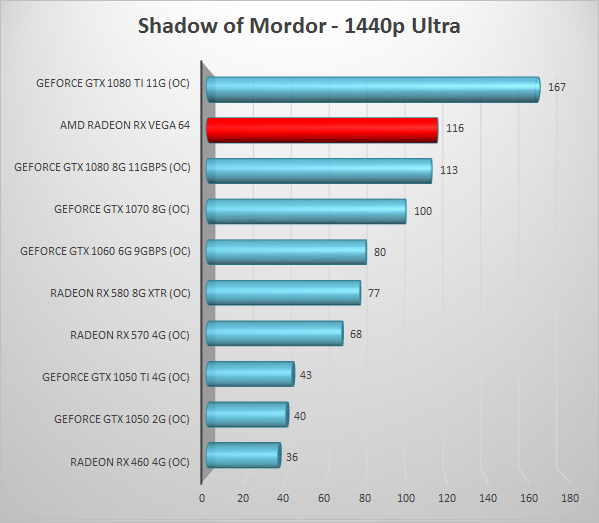

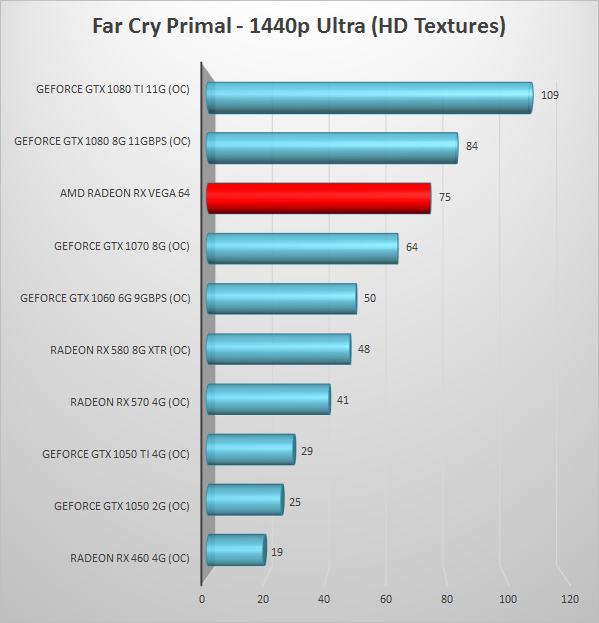

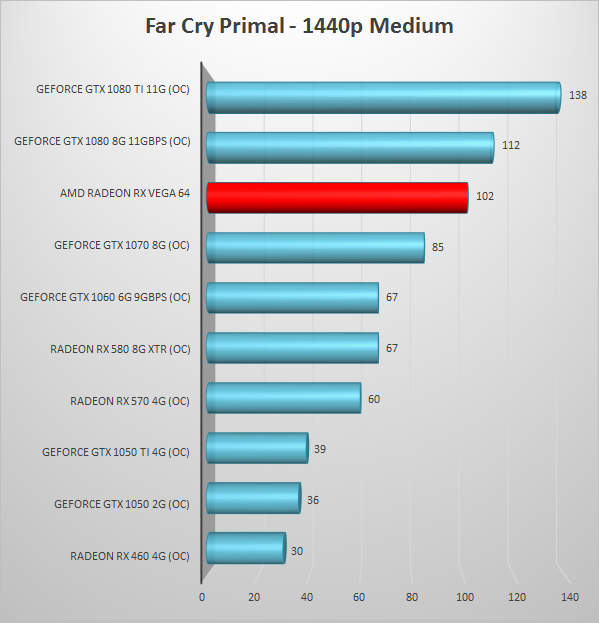

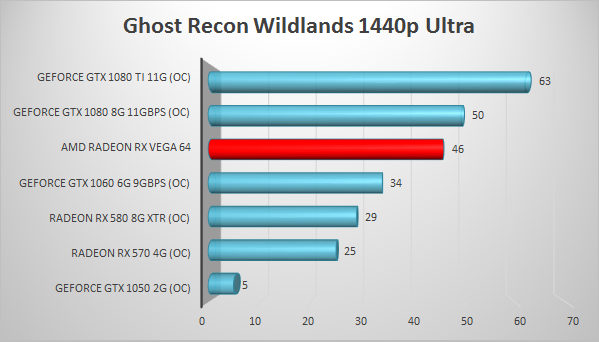

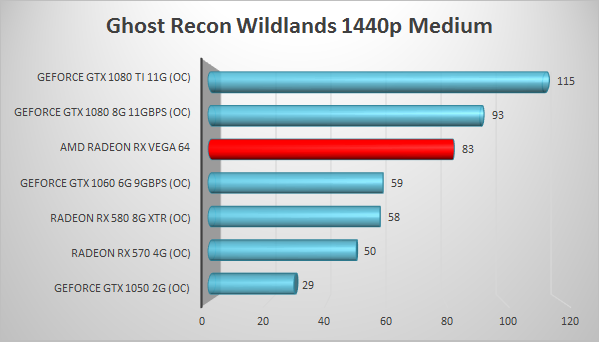

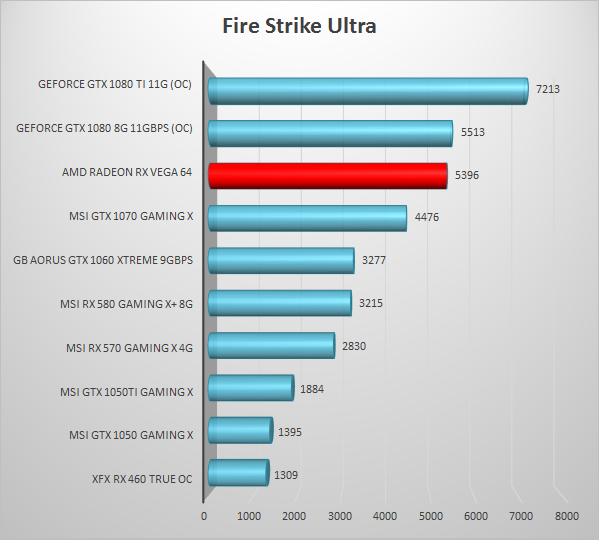

Benchmarks!

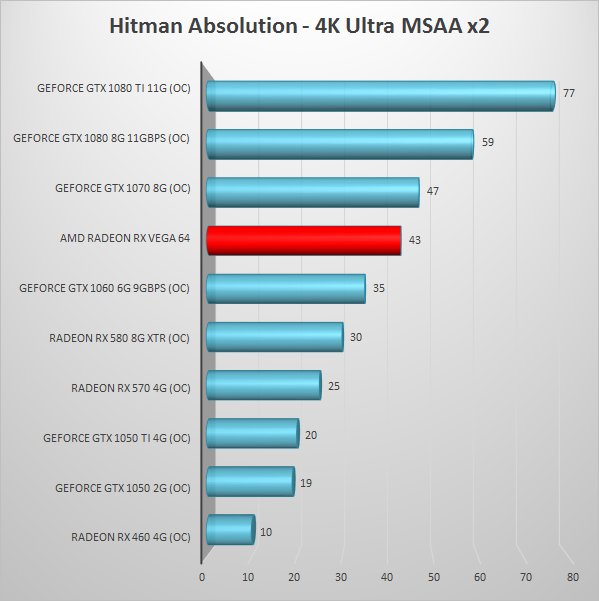

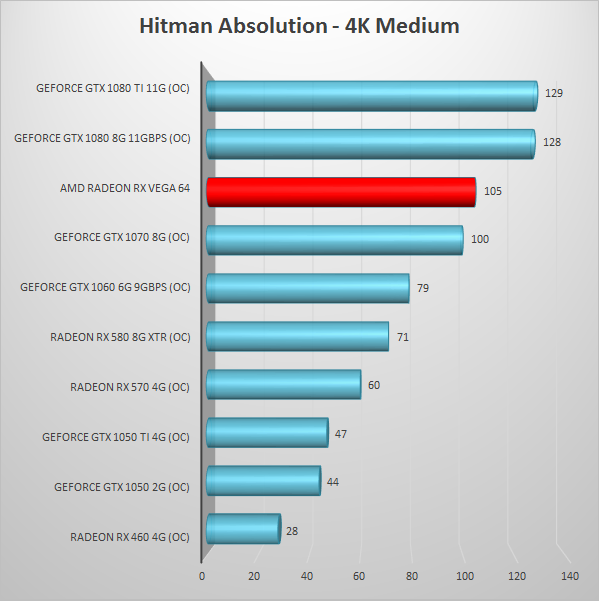

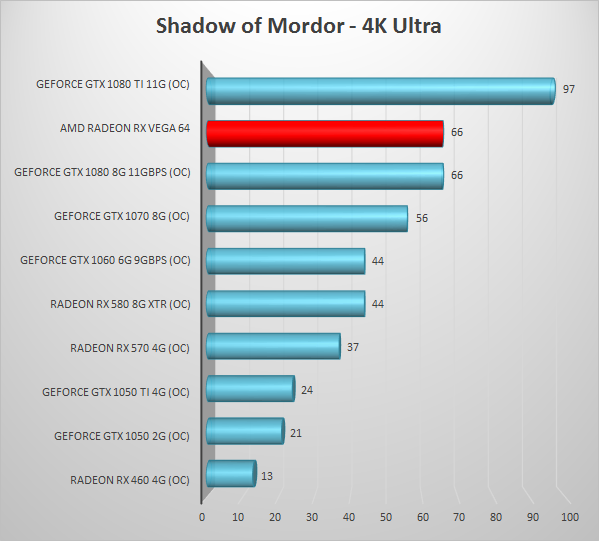

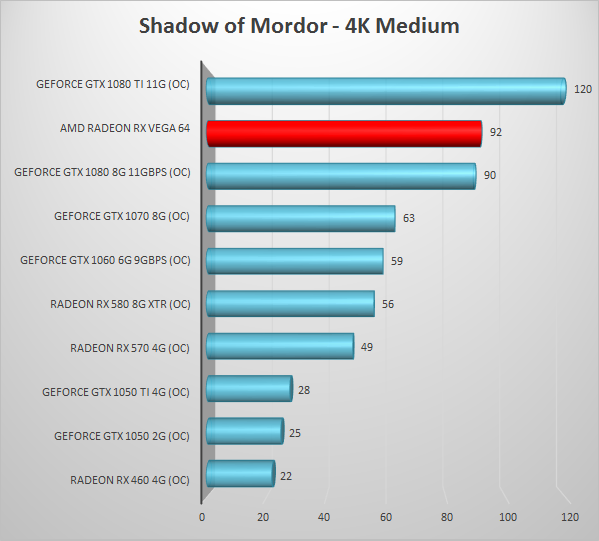

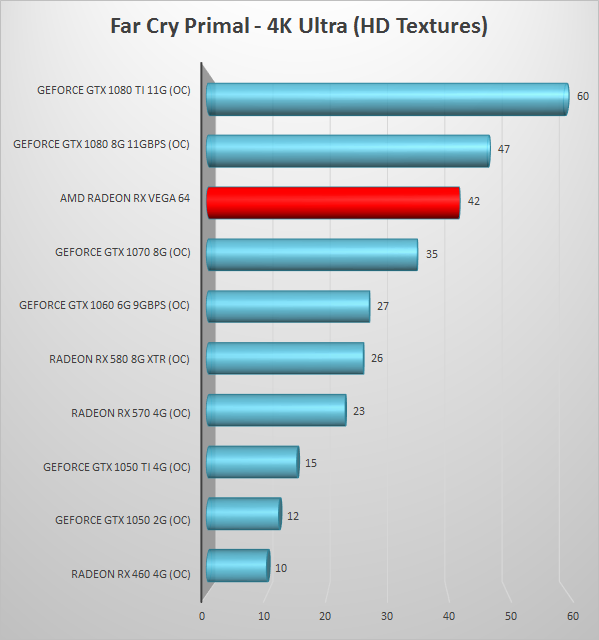

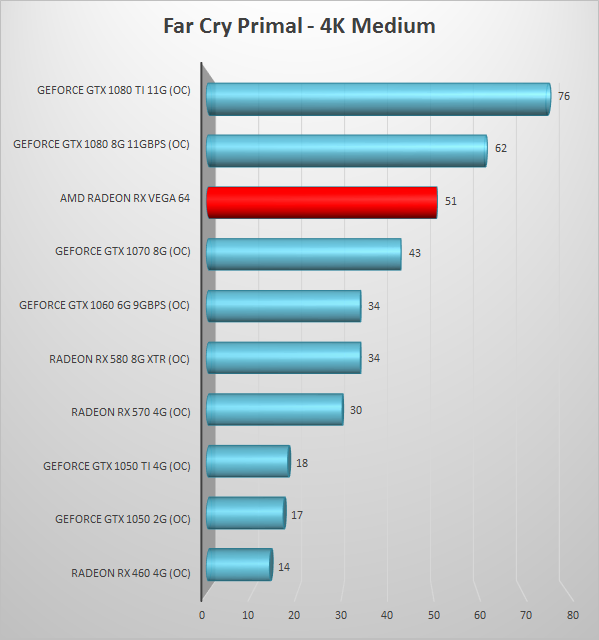

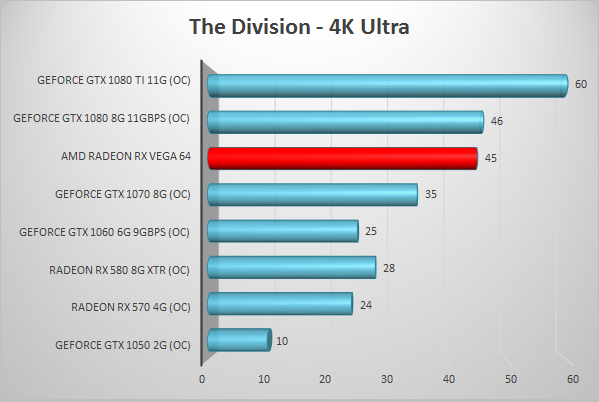

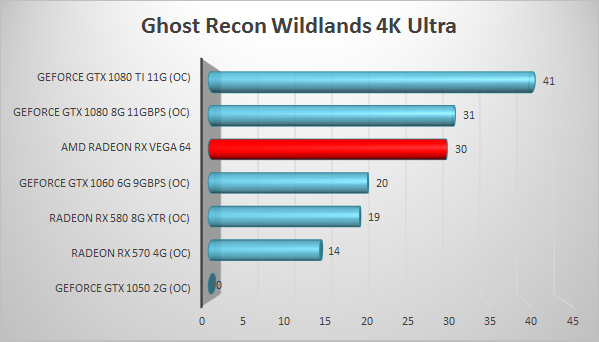

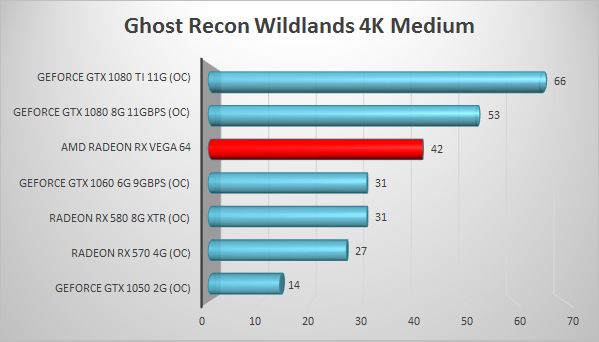

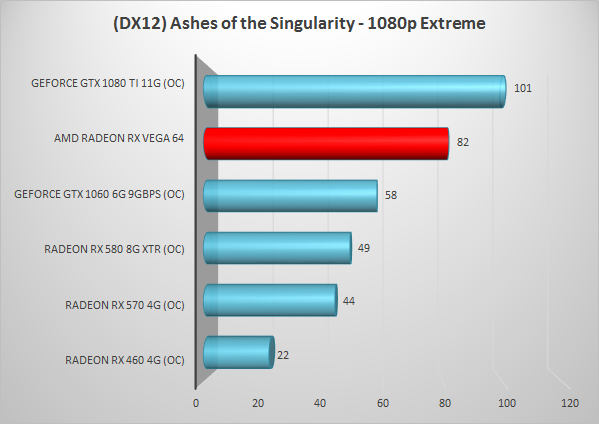

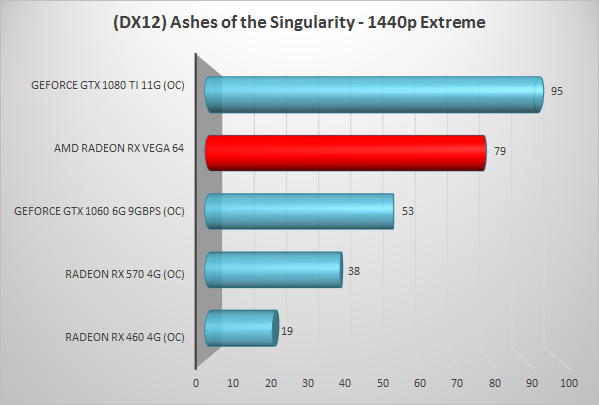

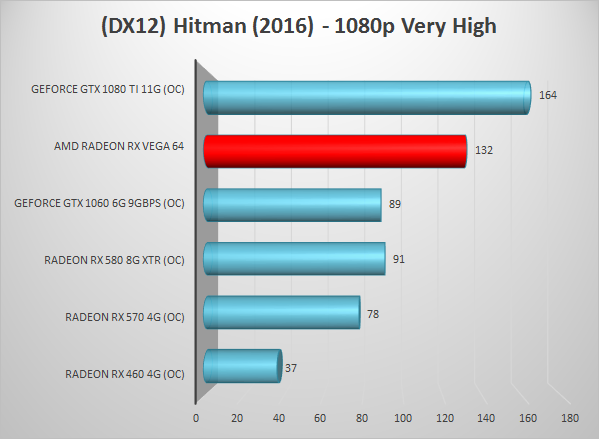

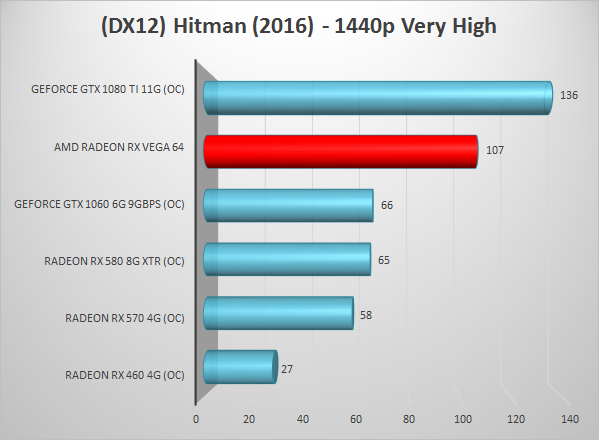

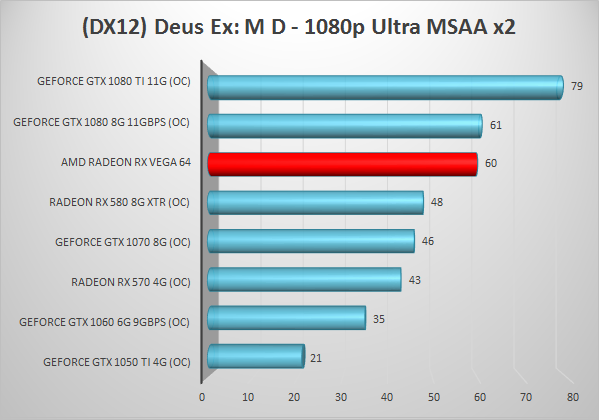

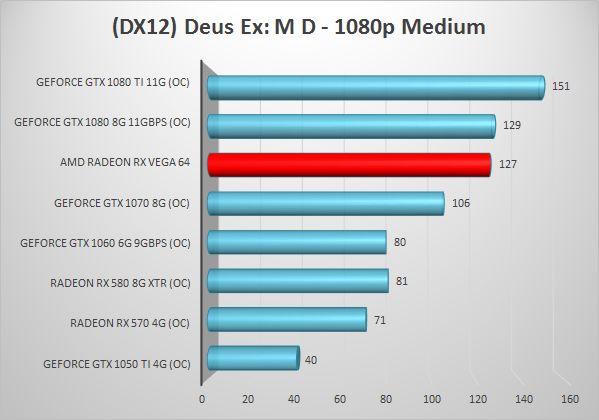

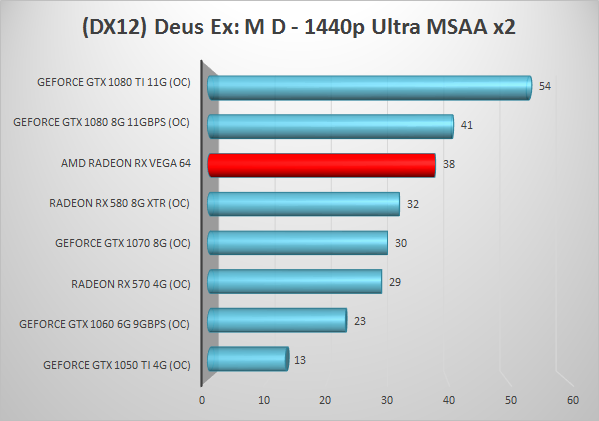

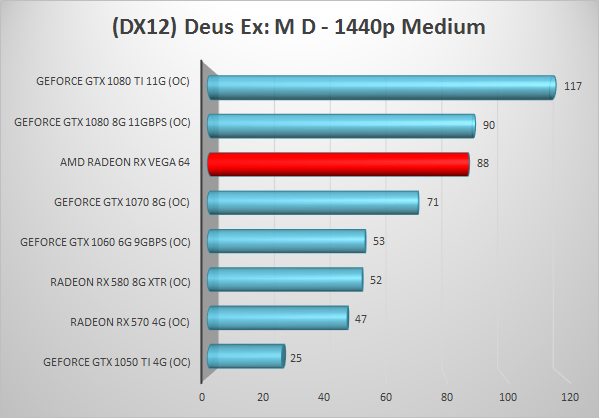

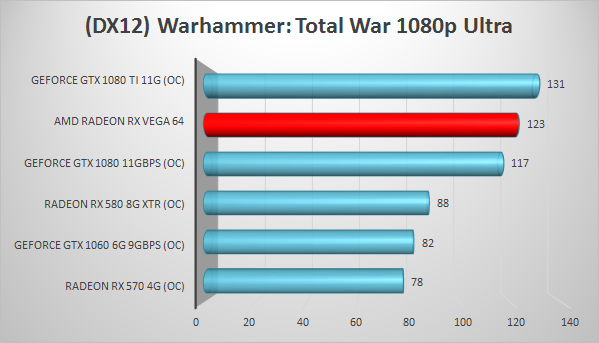

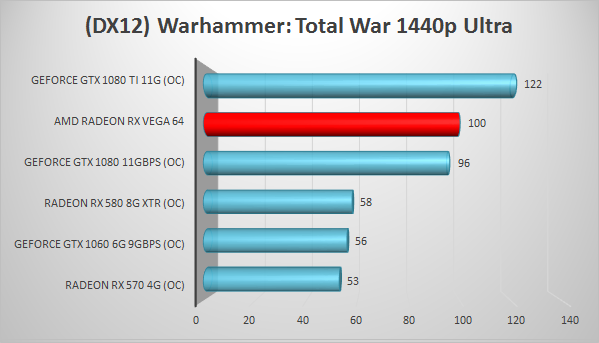

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we achteraf.

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we achteraf.

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we achteraf.

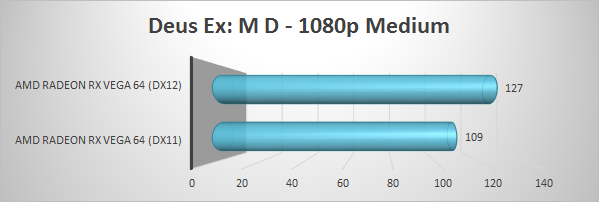

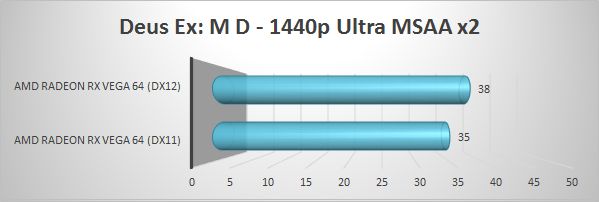

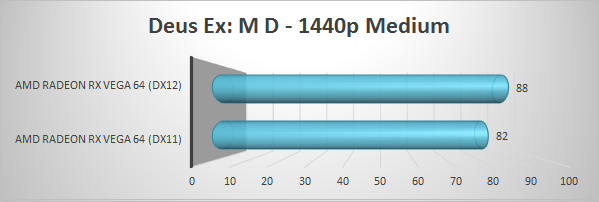

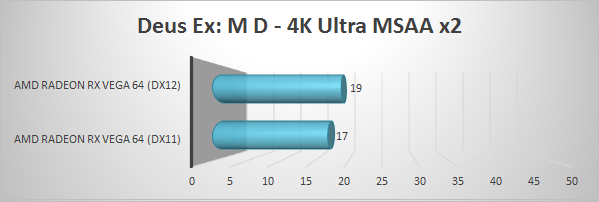

Vergelijking tussen DX11 en DX12:

(Vergelijking Ashes of the Singularity DX11 vs DX12 wordt hier ingevoegd)

In tegenstelling tot voorgaande reviews bevat dit hoofdstuk enkel de resultaten, de bespreking daarvan doen we achteraf.

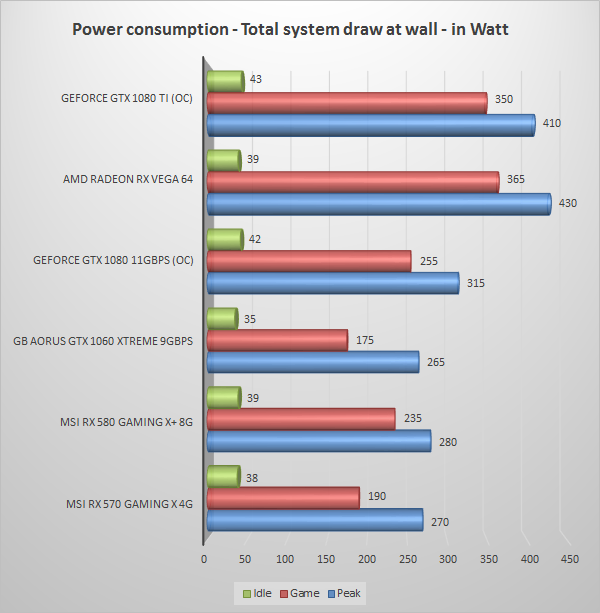

Ook het verbruik van een GPU is een belangrijk punt. Ik heb het verbruik gemeten bij het stopcontact, oftewel het verbruik van het gehele bovenstaande testsysteem, met een Voltcraft 4500PRO. Daarnaast wordt gebruik gemaakt van een basic USB toetsenbord en een USB muis. Die verbruiken uiteraard ook een klein beetje, en op deze manier hoop ik het verbruik van een gangbaar systeem (excl monitor) te tonen. Hoewel deze meting niet exact bepaald wat de kaart verbruikt, krijgen wij zo wel een inzicht in het daadwerkelijke verbruik van een systeem, een redelijke vergelijking van het verbruik van de verschillende kaarten, en een indicatie van welk vermogen voeding geschikt zou zijn voor dit product.

Het verbruik op drie momenten is opgenomen in deze grafiek:

– Het gemiddelde verbruik van de computer gedurende 10 minuten in idle (Dus niet de slaapstand, vergelijkbaar met een beetje mailen of in word/excel werken).

– Het gemiddelde verbruik gedurende enkele specifieke game benchmarks.

– Het piek-verbruik gedurende de hele benchmark sessie.

Prima score op gebied van idle verbruik, deze zit in dezelfde lijn als andere recente AMD en Nvidia kaarten.

Wat load betreft, voor mij kwam het niet als verrassing dat de Radeon RX Vega met zijn prestaties een stukje hoger uit kwam dan we van de RX 580 gewend waren, het productieprocedé is namelijk gelijk, en HBM2 is dan wel efficiënter we zien toch ook een flinke performance boost. Nvidia blijft wel duidelijk meester wat pure efficiëntie betreft, want de snelste GTX 1080 variant die we zagen is gemiddeld genomen toch een flink stuk zuiniger dan de Vega hier. Je zal wel stevig moeten gamen om dat echt te voelen in je rekening, maar als je dat wel doet dan is dat verschil een serieuze overweging. Elke dag een uurtje gaat het verschil niet merken, maar wanneer je dag in dag uit zit te gamen dan loopt het echt in de papieren.

Vega veranderd echter weinig aan ons recente standaard verhaaltje wat voedingen betreft; het gaat namelijk lastig zijn om een voeding te vinden die de twee benodigde 8-pin stekkers heeft die wat vermogen betreft niet voldoet. Gelukkig geen waanzin zoals sommige onzin-leaks al hadden gesuggereerd. Zelfs met de i7 en de videokaart op volle toeren is een 450W voeding in staat het te voeren, al is dat in onze optiek iets krap om als advies mee te geven. Een degelijke 550W voeding is echter geen enkel bezwaar, en behoudt ook wat overclockpotentieel. Verwacht je echt de grenzen van je componenten op te zoeken is een ca 650 Watt model wellicht geen verkeerde investering, zoals we hieronder zullen zien, maar je moet wel echt GPU en CPU hard trappen plus een zwik andere hardware erbij hebben voordat een 550 Watter een probleem gaat worden.

[anchor=q][/anchor]

Ok, dit gaat zeker geen vast onderdeel worden, maar gezien er om werd gevraagd. In de Claymore mining benchmark zet deze kaart ca 30 MH/s neer direct af fabriek. Waar met een minimaal beetje tuning (veel tijd hadden we niet) de 32-33 MH/s uit kwam rollen. Ter vergelijking, we zagen een vergelijkbaar beeld bij een vlotte GTX 1080 Ti. Mining kan dus wel zeker, maar gezien het hogere stroomverbruik lijkt het niet voor de hand te liggen.

In dit hoofdstuk bekijken we de geluidsproductie, doen we een stabiliteitstest (duurtest), en kijken we of er nog meer uit de kaart te halen valt.

Ik kan mij niet herinneren wanneer een referentiemodel voor het laatst de meest voor de hand liggende koeler was om aan te schaffen. Er zijn zeker situaties waarin de blower-stijl koeler tot zijn recht komt, maar in een typische toren is dat niet zo. Wilde je echt lage temps en een fluisterstille koeling onder load kwam je per definitie gewoon op aftermarket modellen uit.

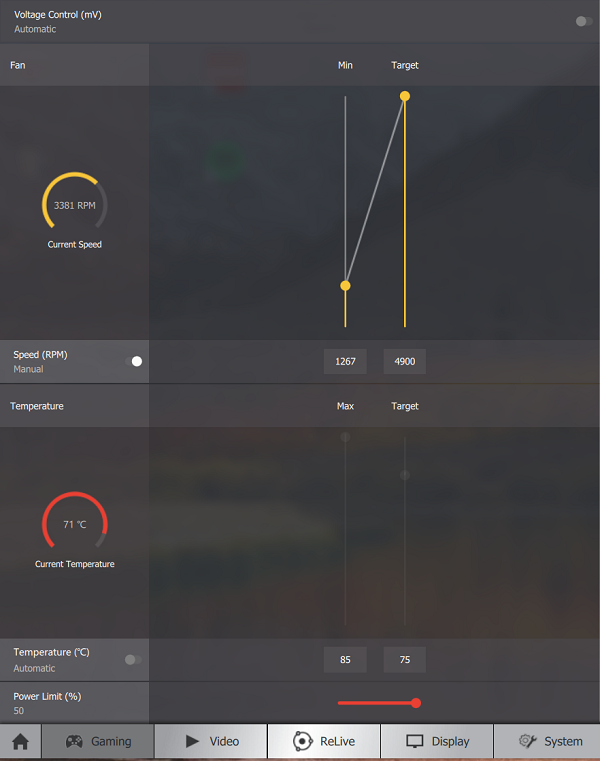

En de RX Vega is geen uitzondering. Het lage idle verbruik zorgt dat de koeler niet boven ambient uitkomt in idle, dus geen zorgen over blazen wanneer je in je spreadsheetje werkt, maar op volle toeren registreren we ca 46 dBA op 50 centimeter afstand van een open testbench. Op zich geen onaardig resultaat voor zij die nog met een oude GTX 280 of 480, of R9 290(X) blower stijl koeler zitten en iets wat een gamer met een beetje headset of speakerset wel ondervangt, maar niet de fluisterstille load oplossingen die we van o.a. Asus ROG Strix-, MSI Gaming-, of Gigabyte Aorus kaarten hebben gezien. Koelers waarbij we ook nog lagere temperaturen verwachten dan dat we hier zien, die zijn best prima, maar verre van spectaculair.

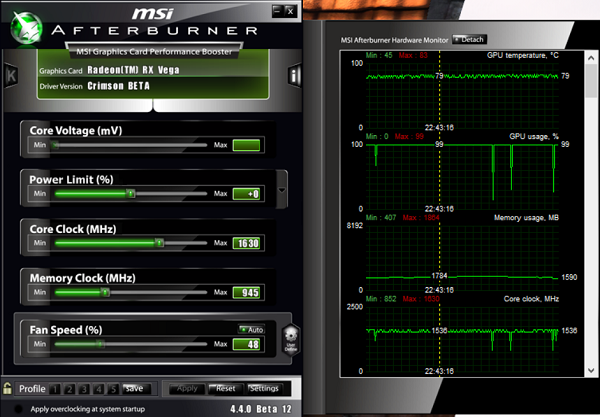

In de duurtest zien we dat de maximale boost niet constant wordt volgehouden, maar dat de kaart tussen de 1536 en 1630 MHz stuitert. Geven we in Radeon Wattman, onderdeel van het driverpakket, de kaart iets meer ademruimte (lees: power limit), dan trekt die lijn echter wel strak. En nog leuker: zonder relevante consequentie voor de geluidsproductie en voor die enkele graad of knullige extra paar Watt uit de muur hoeven we het ook niet te laten. Positief uitgangspunt voor aftermarketkaarten, fijn dat het hier ook in zit, maar lastig te begrijpen waarom die power limit dan net te terughoudend is ingesteld.

En toen gingen we trappen, eigenlijk in de veronderstelling dat AMD de laatste weken en maanden toch echt het maximale uit de RX Vega geknepen zou hebben gezien de pittige concurrenten die ze onder vuur namen.

Maar toen kwamen we al snel bij 1700MHz… 1725… 1750… 1762… en iets daarboven merkten we een incidenteel hikje op dus pinden we hem vast op 1762 MHz; geen onaardige boost! Geheugen van 945MHz naar 1050 MHz bleek ook geen probleem. Iets meer lijkt nog mogelijk, maar veel hoger gaf blue screens terwijl de 1762/1050 combinatie een tijd lang stabiel bleef draaien.

Ook opvallend bleek het feit dat de werkelijke bump in prestaties positief uit viel, waar we recentelijk toch ook afnemende winsten hebben gezien bij het verder overclocken. Meer tijd is nodig om te bepalen of die winst vooral in de core of het geheugen zit, maar een stevige basis is gelegd.

Veel potentie dus, maar de kaart begon in overclock toch aardig te blazen. Gezien de toename in verbruik ook niet heel vreemd eigenlijk, de RX Vega lustte namelijk opeens wel wat extra electrojuice, maar daarmee wel een duidelijk argument dat je voor overclocken ofwel naar een watergekoelde versie wilt kijken, ofwel voor een dikke custom versie wil gaan. Met de power limit vol open en de genoemde 1762/1050 OC, trokken we namelijk ruim 75 Watt meer uit de muur, en dat is ‘nie weinig’ in correct science.

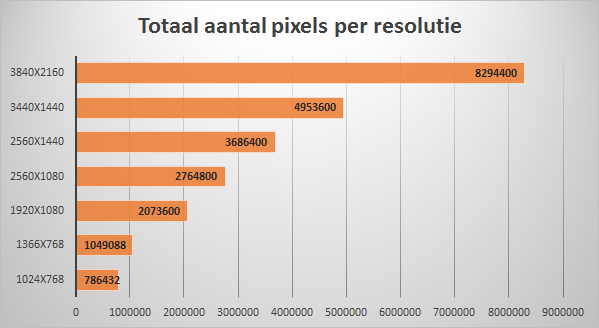

Om andere resoluties te bespreken op basis van bovenstaande resultaten eerst de grafiek met het aantal pixels per resolutie:

Laten we de RX Vega eerst beoordelen op zichzelf, puur op basis van de resoluties die we zien: Waar de AMD Radeon RX 570 en RX 580 echte 1080p kaarten waren zien we hierboven toch de extra prestaties die we eigenlijk willen voor 1440p en verder. Een RX 580 op 2560x1440p is veelal prima vertoeven, maar Vega komt daar toch ook al duidelijk lekkerder uit zijn vel.

Op 4K zien we het natuurlijk wel weer lastiger worden, maar met de toevoeging dat een GTX 1080 daar in een vergelijkbaar bootje zit, en ook de GTX 1080 Ti’s moeten daar toch soms door de knieën. Precies daarom lijkt AMD dan ook zo te hameren op Freesync, want in resoluties voorbij 2560x1440p (en deels ook op 2560x1440p) zit daar gewoon echt de meerwaarde van de Radeon RX Vega. Met Freesync / Adaptive sync als veel voorkomend onderdeel in 3440x1440p panelen, 4K panelen, en zelfs 3840x1600p panelen zoals de LG 38UC99 die we laatste voor ons hadden is dat toch een grote factor die een nieuwe GPU koper naar Vega zal trekken in plaats van Nvidia. Ik zei het bij de GTX 1070’s ten opzichte van de RX 580’s dat Sync techs erg leuk zijn maar dat er weinig boven een grote power-upgrade gaat, maar voor die upgrade zal je al snel honderden euro’s extra moeten neertellen, iets wat wederom onderstreept dat Nvidia en hun (overigens technisch heel knappe) paradepaardjes de meer prijsbewuste kopers toch onder druk zetten.

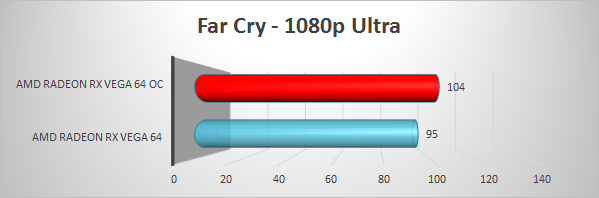

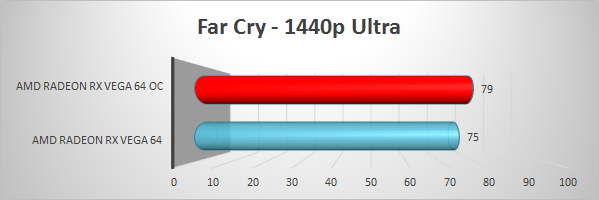

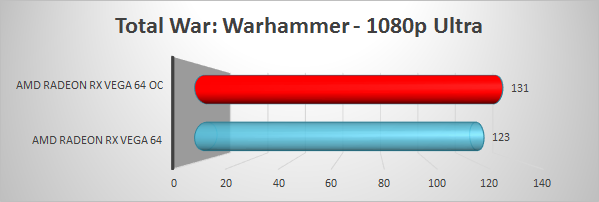

Uiteraard zien we de nodige schommelingen per game, en er zitten er een aantal tussen waarin we Nvidia structureel voorsprong hebben zien pakken. Met uitzondering van Far Cry primal zijn dat echter oudere games, en kunnen we ook nog stellen dat we ook daar niet echt hele spannende andere ervaringen op het beeld krijgen; 1440p op Ultra loopt soepel, op 4K is het verschil te overzien, niet spannender dan een Sync tech zal zijn, of nog belangrijker: de vraag wat een vergelijkbaar stevige custom overclocked Vega gaat doen. Want we krijgen hier een referentie Vega en hij staat naast zo’n beetje de zwaarste GTX 1080 die we kennen.

Die keuze heeft niet mijn voorkeur, maar omdat wij zelden worden voorzien van referentiemodellen hebben we gekozen om voor elke chipset dan maar een model met stevige factory-oc aan te houden in de grafieken, wat de directe vergelijking tussen de GTX 1080 en de stock RX Vega iets schever doet ogen dan werkelijkheid zal worden, maar een alternatief zou ons problemen geven met tal van eerdere chipsets. AMD gaat in hun slides uit van de GTX 1080 Founders Edition, en lijkt Vega 64 dusdanig afgestemd te hebben dat ze daar net boven uit komen, en dat lijkt dan ook niet echt uit de duim gezogen.

Zodra wij de eerste stevige factory-oc Vega voor ons hebben zullen we de Vega baseline ook aan de hand van die resultaten verschuiven, wat uiteindelijk ook de meest realistische weergave is gezien in de praktijk die modellen het meeste over de toonbank gaan. Gezien de eerste overclocked resultaten heb ik er ook vertrouwen in dat de gaten die we hier en daar zien dan ook wel recht worden getrokken en dat ze uiteindelijk in game benchmarks een beetje stuivertje mogen wisselen, we zien tenslotte nu ook al games waarin een stock Vega even snel of nog sneller is dan een dikke core overclock, memory overclock GTX 1080; en dat is een hele mooie kaart om tegen op te boxen. Eerdere suggesties dat Vega tegen de Ti of juist de 1070 op ging boxen lijken in elk geval aardig mis, al lijkt de RX Vega 56 het laatste wel voor zijn rekening te gaan nemen.

Vega is here, and I like it! Ik meende ook zoiets bij Ryzen gezegd te hebben, en net als bij Ryzen moet ik ook hier stellen dat het ook zeker geen verhaal is zonder ‘maar’. Een blik op de financiële situatie van AMD, Nvidia, en Intel maakt het echter niet meer dan vanzelfsprekend dat AMD geen alles-verpletterend product neer gaat zetten maar gericht moet steken in de paar zwakke plekken van de concurrenten. Zij die hadden gehoopt dat AMD met een kaart aan zou komen zetten die de GTX 1080 Ti even aan de kant zou zetten, en nog even een lager prijskaartje (en lager stroomverbruik, why not) als slagroom op de taart had gehad, zijn wellicht teleurgesteld, maar een dergelijke verwachting toont wat gebrek aan realisme.

Voor gamers tellen die omstandigheden echter niet en telt enkel het resultaat, laat daar geen onduidelijkheid over bestaan. Maar voor een goed resultaat voor ‘ons’ is geen Steamroller van een videokaart nodig (maar laten we maar niet praten over hoe AMD een Steamroller voorstelt), daarvoor is een goede, goed gepositioneerde kaart des te interessanter. Toen AMD de eerste Polaris GPU uitbracht, de RX 470 en RX 480’s, waren die interessant niet omdat ze Nvidia verpulverden (die hadden tenslotte al modellen er ruim boven), maar omdat ze een uitstekende koop boden voor een grote doelgroep; genoeg prestaties voor de gangbare beeldformaten, plus het feit dat G-Sync in dat lagere segment onevenredig op het budget drukt.

Met Vega doet AMD iets vergelijkbaars, zij het voor de iets kleinere, iets rijkere doelgroep daarboven die nu iets als een GeForce GTX 1080 voor ogen heeft. Een teleurstelling voor sommigen, daar ben ik van bewust, maar ik ben juist harstikke enthousiast dat we die klasse performance van AMD weer kunnen zien! De laatste keer dat dat het geval was is ruime tijd terug, en toen was de efficiëntie voorsprong van Nvidia dermate groot dat de extra warmte en verbruik voor mij echt argumenten waren om over te stappen; na de 7000-serie van AMD kleurde mijn eigen systeem in elk geval weer groen omdat de stilste AMD kaart niet in de buurt van de stilste Nvidia kaart kwam. Vergis je niet, Nvidia loopt wat prestaties-per-Watt betreft nog altijd een enorme stap voor, Vega architectuur noch HBM2 weet dat flinke gat te overbruggen. Maar met GTX 1080 Ti verbruikniveaus verwachten we dat we net als daar ook kaarten gaan zien die ook fluisterstil hun ding gaan doen. Toch is het wel duidelijk de zwakke plek, want het tientje per jaar extra dat je kwijt bent aan elke dag een uurtje gamen zal het verschil niet maken, maar gamers die serieus uren maken moeten er wel even bij stil staan dat het op kan lopen. AMD kan dan wel hameren op Chill om de prestaties, en daarmee het verbruik, wat praktischer af te stemmen op je scherm, en ook dat is op zich ook best iets om even naar te kijken, het neemt gewoon niet weg dat ze daar een achilleshiel hebben.

AMD zal echt alles op alles moeten zetten om die achterstand in te gaan halen als ze willen blijven concurreren op de lange termijn, want de Pascal chips van vorig jaar lopen dus al voor, en Nvidia zal toch niet stil zitten deze dagen. De opvolger zal wellicht nog niet op de plank liggen, maar het is niet ondenkbaar dat Nvidia een beetje vaart gaat maken om de voorsprong bovenaan de markt weer wat te verstevigen naar die comfortabele marges die we tot vandaag zagen. Laten we eerlijk zijn, we zien AMD weer gezellig langszij varen met hun eigen voor- en nadelen, maar doen dat wel met alle zeilen open.

Terug naar de praktijk: Dat de absolute top-end koper, zij die 800-1000 euro voor een GPU neer kunnen tellen plus nog iets dergelijks voor een monitor geen alternatief wordt geboden met Vega is dan natuurlijk een beetje jammer, al was het maar dat concurrentie in dat topsegment voordelen voor iedereen had gehad, subtop inclusief, maar het is desondanks bijzaak. Voor gamers met een voorbij 1080p paneel is er met Radeon RX Vega wel weer een interessante AMD optie; één die de GTX 1070 achter zich laat, rondom de GTX 1080 danst, en dan enkel voor die (normaliter duidelijk duurdere) GTX 1080 Ti moet buigen. In dat plaatje zie ik geen reden tot klagen.

Met het sterk toenemende aantal Freesync panelen met 2560x1440p-, 3440x1440p- of zelfs 4K resolutie heeft AMD dan toch ook een stevige troef in huis, één waar AMD tot vermoeienis op hamert alsof reviewers dat zelf niet snappen en alsof daar echt wel alles om draait (oh wait, it does), maar desondanks een zeer valide troef. Dat Freesync al aanwezig in enkele van onze schermen zonder dat we er bij stil hebben gestaan, of althans zonder dat we de meerprijs voor G-Sync wilden neerleggen, is een sterke indicatie dat ze in die strijd, althans voor de grotere niet-extreem-rijke doelgroep, toch een voordeel in huis hebben. Wanneer gamen wel een wens is, maar niet het enige dat telt, voelt AMD dan als een aantrekkelijke optie. Nvidia houdt een goede grip op de top-end GPU en monitor combinaties, en zeker zij die dag-in nacht-in gamen zullen dan even naar dat voordeel in stroomverbruik willen kijken versus de ‘besparing’ van Freesync, maar een gezonde strijd versus de GTX 1080 is het afhankelijk van je eigen eisen alsnog. Overigens verwacht ik niet dat AMD die underdog positie inneemt omdat het een lief bedrijf is, als ze een Ti-killer hadden kunnen bouwen hadden ze dat vast gedaan, maar dat is uiteindelijk ook niet meer dan een bijzaak bij je GPU keuze.

Verder nog even de nodige slagen om de arm, want dit is dag één met AMD Radeon Vega, en in typische AMD-stijl is het aantal dagen dat we konden testen voor de officiële release op één handje te tellen (En AMD discrimineert niet naar reviewers die met slechts drie vingers op een hand geboren zijn). Dat houdt in dat ik nog optimalisaties verwacht wat de chip prestaties betreft, en bovenal: binnen afzienbare tijd de eerste custom modellen verwacht te zien met dikkere, krachtigere en stillere koeloplossing, ongetwijfeld aangevuld met nog wat pittigere overclocks. Zoals vaker is een referentiemodel best leuk en niet eens extreem luid, maar als je echt koel en vooral echt stil wil dan lijkt eventjes wachten op aftermarket modellen gewoon wijsheid. We hebben zeker potentie gezien, maar het is echt aan de board partners om die nu te vertalen in de interessante aankoop. Ook zullen er ongetwijfeld nog aardige verschuivingen plaatsvinden wat de prijzen betreft en de nodige partijen proberen te profiteren van haastige spoed bij de launch, maar dat is al jaren zo ongeacht het merk of de chip die uitkomt.

De basis die we vandaag zien is echter een mooi uitgangspunt voor meer en interessante concurrentie in het GPU midden- tot midden-hoge segment. En net als in de CPU markt weinig beter dan weer wat gezonde concurrentie te zien in een segment tot dusver gedomineerd door één partij, zelfs als het enige resultaat is dat Nvidia even ‘iets’ terugschiet zou het al winst voor de koper betekenen. Dat is wellicht geen spektakel die de assen van grafieken omver gooit, maar toch een aantrekkelijke en waardevolle toevoeging voor tal van gamers met die voorbij-1080p wens.

Een geschikte award bij een nieuwe chipset is wel een lastig punt. Ons advies is, tenzij je niet kan wachten, even aan te zien hoe het gaat met custom kaarten en hoe de prijzen verlopen. Voor de AMD Radeon RX Vega chipset an sich lijkt het label ‘aanrader’ wel op zijn plaats, zoals altijd uiteraard binnen de hierboven uitgezette lijnen.

To-do:

– Toevoegen enkele ontbrekende grafieken (o.a. GTA V, Ashes DX11 vs DX12)

– Toevoegen un-watermarked slides mbt Vega tech.